Chiny wyciągają asa z rękawa. Europa może tylko zgrzytać zębami

Chińczycy wyprzedzili nawet własne plany. CXMT ruszyło już podobno z masową produkcją pamięci niezbędnych do budowy akceleratorów AI i HPC.

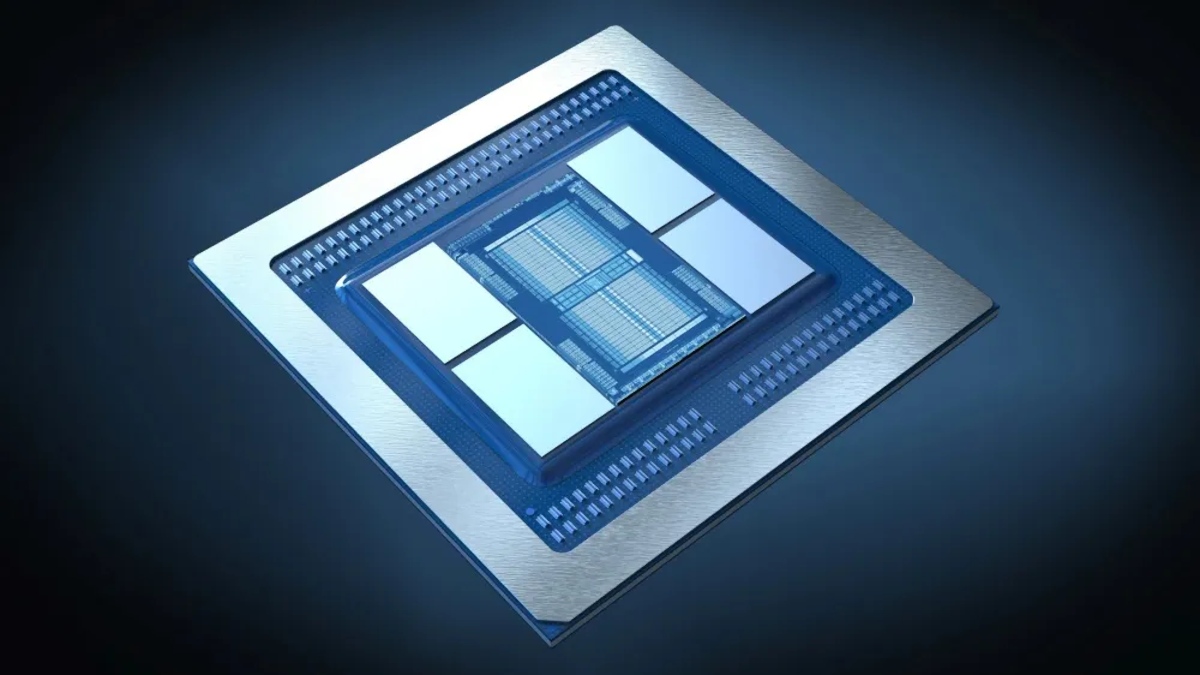

Jednym z ważniejszych elementów akceleratorów AI jest pamięć VRAM. Mowa zarówno o jej pojemności, jak i wydajności. To właśnie dlatego sprzęt do profesjonalnej pracy ze sztuczną inteligencją korzysta z nowszych i droższych kości w standardzie HBM (High Bandwidth Memory), a nie jak układy konsumenckie z GDDR.

Chiny zyskują powoli niezależność na rynku AI

Największymi producentami HBM jest Samsung, Micron oraz SK hynix, a więc Korea Południowa oraz Stany Zjednoczone. Jednak już niedługo do tego grona mogą dołączyć również Chiny.

Jak donosi redakcja Digi Times, ChangXin Memory Technologies (CXMT) rozpoczęło masową produkcję pamięci w standardzie HBM2. Jeśli doniesienia te są prawdziwe, to znacząco wyprzedzono wcześniejsze plany, które zakładały ruszenie z produkcją "do 2026 roku". Oczywiście pozostaje pytanie jak duży jest uzysk.

A jak ma się to do wspomnianych wcześniej firm? Cóż, Samsung, Micron i SK hynix od dawna oferują wydajniejsze kości HBM3 i HBM3e. Znaleźć je można m.in. w układach NVIDIA Hopper. Producenci szykują się też powoli do rozpoczęcia produkcji pamięci w standardzie HBM4.

Mimo wszystko osiągnięcie CXMT pozwoli Chińczykom na swoistą samowystarczalność, zwłaszcza w obliczu sankcji nakładanych przez USA na eksport wydajnych akceleratorów AI do Chin. HBM2 jest kluczową technologią dla układów Huawei Ascend 910.