AMD rozbił hegemonię Intela, teraz idzie po NVIDIA

W świecie serwerów jest nudno — kolejny raz AMD tłucze bez trudu Intela, tym razem jednak z główki dostaje też NVIDIA. AMD właśnie wychodzi na prowadzenie w kategorii sztucznej inteligencji.

Intensywny poranek w San Francisco

Agenda wielkiej biznesowej konferencji AMD w San Francisco była bardzo napięta. Jak zawsze przy takich wydarzeniach, AMD zaserwowało nam wielką salwę konkretów, intrygujących z punktu widzenia nerdów (i specjalistycznego rynku) cyferek, ponownie też zdystansowało się od konkurencji wielkim zapasem mocy obliczeniowej.

Sam jednak wyczekiwałem najbardziej nie tyle nowych procesorów do wielkich centrów danych, ile rozwiązań dotyczących sztucznej inteligencji. Bo to właśnie tam, w San Francisco mogłem zobaczyć, jak wygląda AI od strony kuchni i nawet wziąć w dłonie kawałki krzemu odpowiedzialne za moc obliczeniową modeli generatywnych Mety, Microsoftu, Amazonu czy Google'a. Nie bez powodu Lisa Su, prezes i dyrektor generalny AMD, akceleratory AI zostawiła na deser. Bardzo smakowity deser.

W pełni graficzna akceleracja

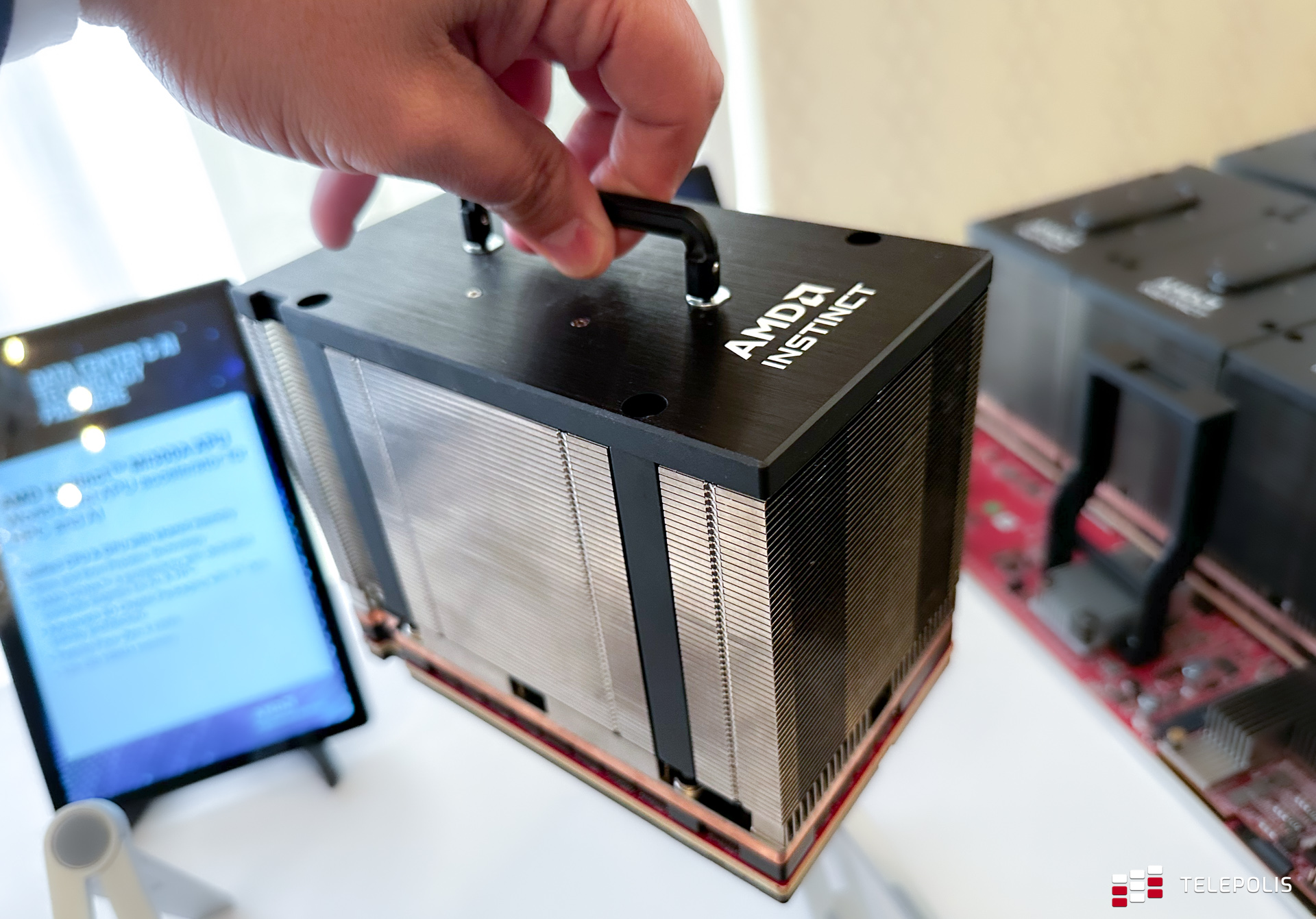

Obok AMD Instinct MI300A, chipletowego akceleratora AI opartego na litografii TSMC N6 + N5 (146 mln tranzystorów), AMD zaprezentowało w San Francisco prawdziwego potwora — AMD Instinct MI300X. Zamiast stanowiących CPU 24 rdzeni Zen 4 (1 x CPU + 3 x GPU), dostajemy jeszcze więcej rdzeni graficznych (0 x CPU + 4 x GPU). Łącznie jest ich aż 304, na co składają się 4 moduły GPU, każdy po 2 chiplety z 40 CU, przy czym w pojedynczym chiplecie aktywnych jest 38 rdzeni graficznych (łącznie 76 na jedno GPU).

Moduły te obłożone zostały kośmi pamięci nowej generacji (stosy HBM3 po 24 GB każda), dając łączną pojemność aż 192 GB VRAM-u o astronomicznej przepustowości 5,6 TB/s.

Dla przypomnienia, konkurencyjne układy NVIDIA H100 sięgają 80 GB pamięci VRAM i przepustowości 3,3 TB/s, mają też znacznie mniej tranzystorów, bo 80 mld w stosunku do 153 mld tranzystorów w AMD Instinct MI300X. Co ważne, wszystkie elementy MI300A i MI300X są równomiernie rozłożone w jednym, dużym układzie, co pozwala na proste i zarazem wydajne odprowadzanie ciepła, jak i łączenie jednostek w łatwe do zaimplementowania klastry po 8 sztuk.

Po co to wszystko?

Zastanawialiście się kiedyś, ile tak właściwie kosztuje wygenerowanie jednej odpowiedzi przez ChatGPT? Z raportu Dylana Patela, szefa zespołu analityków w SemiAnalysis wynika, że jedno pytanie — niezależnie od tego, czy pytamy o walkę z rakiem, czy datę urodzin Britney Spears to wydatek średnio aż 1,5 zł.

Obok samych kosztów finansowych, zapotrzebowanie na AI rośnie tak dynamicznie, że realnym zagrożeniem staje się jego wpływ na środowisko naturalne. Pomimo zaś głosów, że wielkie modele AI są ślepym zaułkiem w rozwoju sztucznej inteligencji, nie widać radykalnego odwrotu od nich. Najbardziej złożone modele nadal puchną, nawet uczone coraz lepszymi technikami.

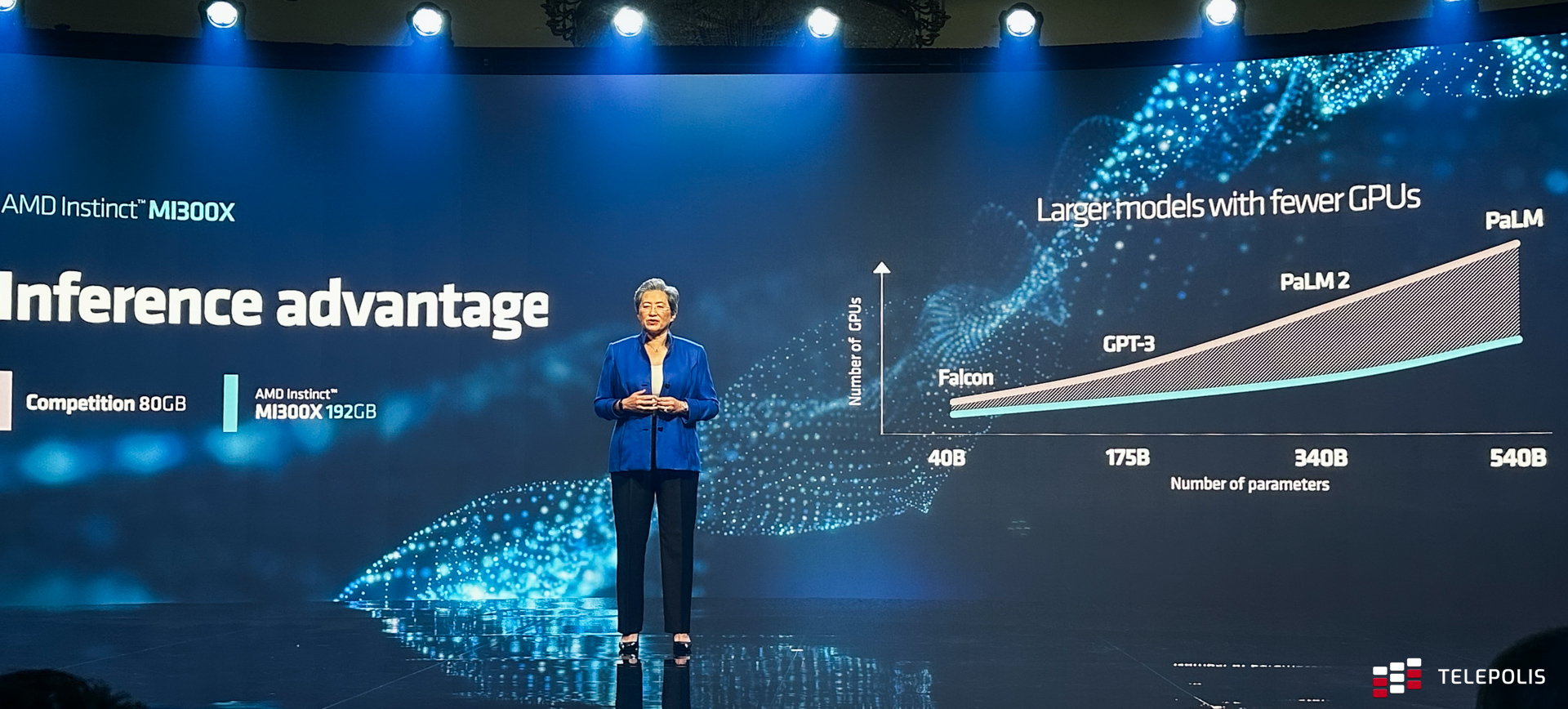

Ten wielki apetyt na programistycznym froncie musimy jakoś utrzymać w ryzach z pomocą coraz bardziej efektywnych rozwiązań sprzętowych — zarówno pod względem wydajności, pojemności pamięci, jak i zużycia energii w przeliczeniu na liczbę operacji. I właśnie tutaj AMD wchodzi cały na biało czerwono. Bo choć zużycie energii przez jeden akcelerator AMD Instinct MI300X sięga 750 W, to jego moc obliczeniowa jest wystarczająca nawet do samodzielnego dźwignięcia potężnego modelu Falcon 40B.

Falcon 40N to obecnie największy opensource'owy model językowy — ma pierwsze miejsce w publicznej tabeli liderów Hugging Face Open LLM. Składa się na niego aż 40 mld parametrów, a wytrenowany został on na 1 bilionie tokenów. Amazon Web Services zadebiutował z Falconem podczas konferencji AMD. Lisa Su, prezes i dyrektor generalny AMD, pokazała potęgę akceleratora AMD Instinct MI300X właśnie na jego przykładzie. Podczas wydarzenia pojedynczy akcelerator zaprzęgnięty został do stworzenia poematu na temat San Francisco, wszystko to na oczach zgromadzonych mediów i całego świata, który oglądał transmisję w Internecie, rzecz jasna przy gromkim aplauzie.

Powiecie e tam, Chat GPT jest jeszcze większy, ma 175 mld parametrów (trzymany w Azure, usłudze Microsoftu korzystającej z rozwiązań AMD). Jest jeszcze PaLM2 na 340 mld i PaLM na 540 mld parametrów. Ale to właśnie AMD przychodzi ze wsparciem dla nich — teraz do obsługi takich kolosów wystarczy mniej niż połowa GPU, gdzie do porównania użyte zostały — a jakże, najlepsze akceleratory z oferty NVIDIA — H100 z mizernymi na tle AMD zaledwie 80 GB pamięci VRAM, w dodatku o znacznie mniejszej wydajności.

Czy ten wyścig zbrojeń jest w ogóle konieczny? Coraz częściej mówi się o tym, że to małe, lepiej wyszkolone modele językowe są przyszłością AI

Takie pytanie zadaliśmy podczas panelu dyskusyjnego poświęconego akceleratorom AI, wspominając, że coraz częściej pojawiają się głosy, że przyszłością AI nie są duże modele językowe, lecz znacznie mniejsze, za to trenowane doskonalszymi technikami.

Najlepsza odpowiedź na to pytanie jest w tym momencie taka, że wydarzy się po trochu wszystkiego. Mocno wierzę, i widzę pierwsze oznaki w branży, że będziemy świadkami dalszego rośnięcia modeli i widzę tutaj jedną z gałęzi (rozwoju AI — przyp. red.).

Czy zobaczymy więcej mniejszych, bardziej wyspecjalizowanych modeli, które będziemy mogli w lepszy sposób kontrolować i obsługiwać? Tak, wciąż jednak myślę, że będą one nadal napędzać olbrzymie zapotrzebowanie na sprzęt.

Być może będzie większe zapotrzebowanie na duże pojedyncze klastry do trenowania tych największych modeli, a może potrzeba będzie więcej zmodyfikowanych klastrów do trenowania mniejszych modeli. Ten rynek robi się coraz większy i tak wiele się na nim dzieje, że myślę, że trzeba być przygotowanym na każdy z tych scenariuszy, a obecny stan utrzyma się jeszcze przez jakiś czas.

- odpowiedział TELEPOLIS.PL Bradley McCredie, Corporate Vice President, GPU Platforms w AMD.

O tym, że nie ma jednej, idealnej ścieżko rozwoju modeli sztucznej inteligencji powiedział nam także Clement Delangue - CEO Hugging Face:

Obserwujemy to, o co pytasz na naszej platformie, gdzie przeszło 50 tys. dostępnych aktualnie modeli liczy od kilku tysięcy do nawet ponad 200 mld parametrów. I widzimy, że każdy z tych modeli jest w użyciu. Przyjdzie nam żyć w świecie, w którym będą istniały coraz większe modele. Są one dobre szczególnie w przypadku bardzo ogólnych zastosowań, gdy chcesz "wygooglować" odpowiedź na każde możliwe pytanie. Z drugiej strony jednak, jeśli szukasz pomocy u chatbota na stronie banku, nie potrzebujesz odpowiedzi na pytania o sens życia. I tutaj lepiej sprawdzi się mniejszy, odpowiednio zoptymalizowany i bardziej wyspecjalizowany model.

Modele językowe będą niczym repozytoria na GitHubie

Jak przekonywał nas Clement Delangue, szybko zmieni się sposób postrzegania modeli językowych na ten znany od lat programistom. Będą one jak repozytoria na GitHubie, z których będziemy mogli swobodnie wybierać odpowiednie dla nas narzędzia.

Modele będą jak repozytoria. W taki sam sposób jak mamy setki milionów repozytoriów kodu na GitHubie, gdzie każdy zasób różni się od innego, dostaniemy setki milionów modeli AI, różniących się od siebie wielkością w zależności od zastosowań.

- odpowiedział TELEPOLIS.PL Clement Delangue, CEO Hugging Face.

Wypowiedzi tych znakomitych ekspertów kolejny raz utwierdzają nas w przekonaniu, że nie istnieje jeden idealny model AI. Nie ma jednej drogi rozwoju i miliony pomysłów będą realizowane równolegle. A to, jakbyśmy nie chcieli wykręcić, będzie potrzebowało mocy obliczeniowej, jaka się jeszcze nie śniła ludzkości.

Aż tak złożony sprzęt to wielkie wyzwanie

Prezentacja muskułów przez AMD to jednak jedno, a realizacja to druga, o wiele trudniejsza część przedsięwzięcia. Choć AMD zgromadziło w czasie eventu pełnych entuzjazmu przedstawicieli największych dostawców centrów danych i rozwiązań AI na świecie, teraz trzeba im jakoś te Instincty wyprodukować i dostarczyć w zadowalających ilościach.

Kluczowe mogą się w tym przypadku okazać łańcuchy dostaw pamięci HBM3 (produkowane przez SK hynix), w które AMD szczodrze wyposaża swoje akceleratory, ale i samo wykonanie nowych akceleratorów to czasochłonne wyzwanie dla TSMC. Pozostaje mieć nadzieję, że AMD będzie rozpychać się łokciami u wodopoju wyjątkowo skutecznie, bo przecież nic tak dobrze nie działa na nas — końcowych użytkowników — jak skuteczna konkurencja na rynku.