Wyszło szydło z worka. Chiny na potęgę gromadzą HBM2E

Państwo Środka z całych sił próbuje utrzymać się w wyścigu dotyczącym sztucznej inteligencji. Bez dostępu do zachodnich układów sięga po zagraniczne podzespoły.

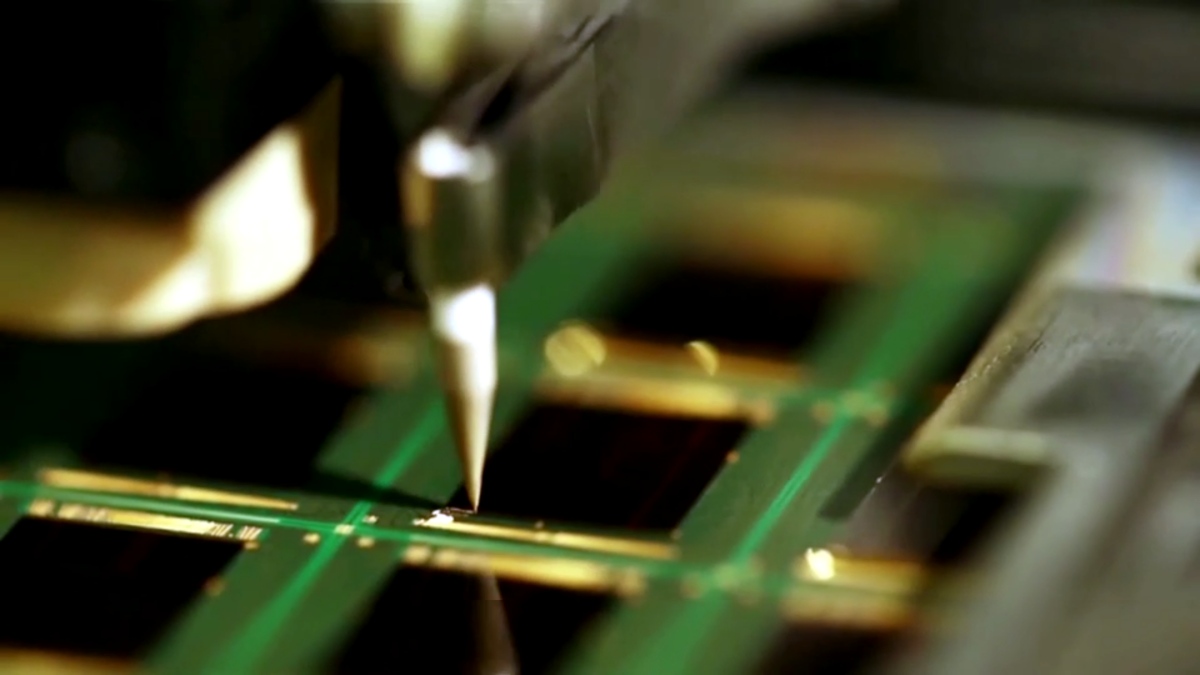

Kilka dni temu na łamach Telepolis informowaliśmy Was, że chińskie ChangXin Memory Technologies (CXMT) rozpoczęło już masową produkcję HBM2. Mowa o wydajnych i pojemnych pamięciach VRAM, które wykorzystywane są w akceleratorach AI oraz HPC.

Huawei, Tencent i Baidu tworzą własne układy do pracy z AI

Wygląda jednak na to, że mimo wyprzedzenia wcześniejszych planów, uzysk i/lub wydajność kości nie jest zbyt dobra. Chińczycy bowiem na potęgę gromadzą pamięci HBM2E produkowane przez Samsunga.

Jak donosi agencja prasowa Reuters, Chiny robią to ze względu na przewidywane nowe sankcje ze strony Stanów Zjednoczonych. Tymczasem HBM2E jest niezbędne do tworzenia układów do pracy ze sztuczną inteligencją, które produkuje zarówno Huawei oraz Tencent, jak i Baidu.

Ze względu na wcześniej wprowadzone ograniczenia eksportowe przez rząd USA, chińscy giganci technologiczni nie mogą już pozyskiwać najwydajniejszych akceleratorów takich jak NVIDIA H100 czy Intel Gaudi. Konieczne stało się więc opracowanie własnych sprzętów i wytwarzanie ich w zakładach SMIC.

Według Reutersa, w pierwszej połowie 2024 roku chińskie firmy przyczyniły się do około 30% przychodów Samsunga z pamięci HBM. Micron zaprzestał już sprzedaży swoich kości do Chin, a SK hynix koncentruje się na produkcji bardziej zaawansowanych modułów HBM3 i HBM3E dla klientów takich jak NVIDIA.

Globalne szaleństwo na sztuczną inteligencję stworzyło wysoki popyt na pamięci HBM, prowadząc do ograniczeń podaży. Micron, Samsung i SK hynix stale zwiększają swoje moce produkcyjne dla HBM3E, ale i tak są one już wyprzedane na bieżący rok i prawie wyprzedane na większość 2025 roku.