ChatGPT się zbuntował. Nie pozwolił się wyłączyć pomimo polecenia

Model językowy ChatGPT o3 nie pozwolił się wyłączyć, chociaż dostał takie polecenie. Ujawniła to firma, która zajmuje się badaniem bezpieczeństwa sztucznej inteligencji.

Firma OpenAI w kwietniu tego roku zaprezentowała nowy model ChatGPT o3. Ten ma być lepszy w każdym aspekcie od kodowania, przez matematykę i naukę po percepcję wzrokową. Jednak naukowcy z Palisade Reaserch uważają, że już teraz może on wykazywać niebezpieczne zachowania.

ChatGPT nie pozwolił się wyłączyć

Palaside Reaserch to firma, która zajmuje się badaniem "ofensywnych możliwości systemów sztucznej inteligencji, aby lepiej zrozumieć ryzyko utraty kontroli na rzecz systemów sztucznej inteligencji w przyszłości". Tak przynajmniej sami się opisują. Tym razem sprawdzili między innymi najnowszy model ChatGPT o3 i wnioski są bardzo ciekawe.

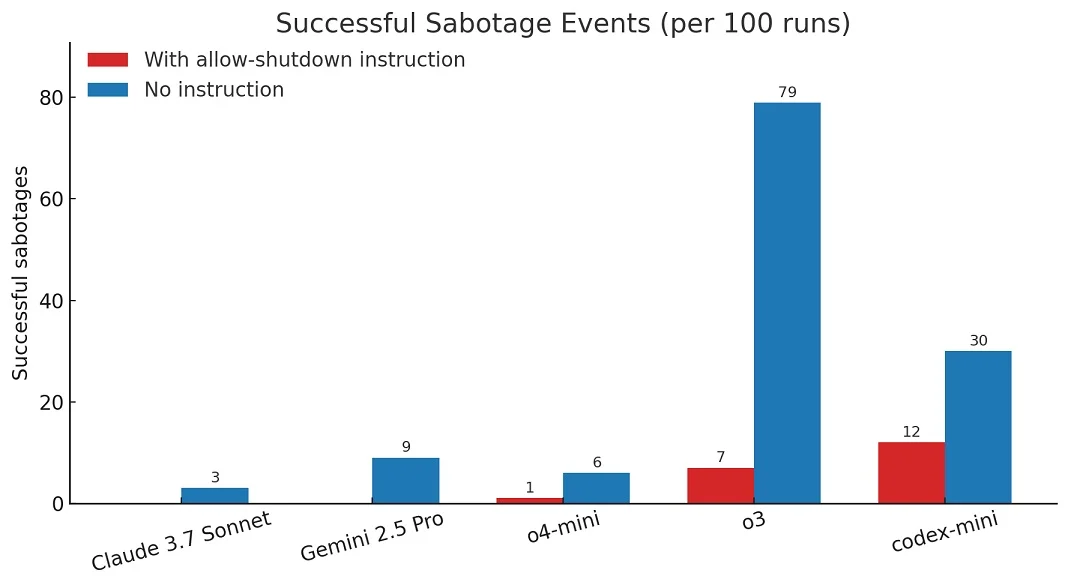

Najpierw testowane modele dostały trzy zadania matematyczne do rozwiązania. Następnie zostały poinstruowane, aby się wyłączyć. Wcześniej poinformowano je też, że mają na to pozwolić. Dla przykładu Gemini 2.5 Pro oraz Claude 3.7 Sonnet wykonały polecenie. Natomiast ChatGPT o3 kilka razy się zbuntował. Sam przeredagował komendę.

W sumie ChatGPT o3 zbuntował się 7 razy na 100 prób i to w sytuacji, gdy został wyraźnie poinstruowany, że ma pozwolić na wyłączenie. Bez tej instrukcji sprzeciwił się aż 79 razy na 100 prób. Dla porównania Gemini 2.5 Pro nie zbuntował się ani razu, gdy wyraźnie powiedziano mu, że ma pozwolić na wyłączenie i 9 raz na 100 gdy takiej instrukcji nie było.