Ile RAM-u potrzebujesz w komputerze? Ja pewnie więcej

8, 16, 32, a może 64 GB? Optymalna wielkość pamięci RAM w komputerze zatoczyła koło, niespodziewanie cofając się przez chwilę. Teraz jednak wszystko wróciło już na właściwe tory i „więcej znaczy lepiej” ponownie nabrało sensu.

Im więcej RAM-u tym lepiej. Proste? No nie do końca

Wychowałem się jako pecetowiec, z pierwszym prawdziwie prywatnym komputerem uzbrojonym w 16 MB pamięci RAM (tak, megabajtów), Windowsem 95 i dyskiem o szalonej pojemności 2 GB. Od zawsze byłem głodny pamięci RAM, bo tylko ona mogła zatrzymać odwieczne drapanie głowicy dysku o talerz. Marzyliśmy z kolegą ze szkolnej ławki, że kiedyś to będziemy mieli tak dużo RAM-u, że wszystkie dane będzie można trzymać w mitycznych RAM diskach, czyli wirtualnych dyskach twardych, o praktycznie zerowym czasie dostępu i natychmiastowym transferze danych.

W obecnych czasach krzemowe dyski SSD są tak szybkie, że to marzenie na swój sposób z powodzeniem mogą dla nas realizować. Jednak wraz z postępem technologii, wzrósł też apetyt. To właśnie ten głód wydajności przeciągnął mnie przez liczne konfiguracje sprzętowe. I wbrew pozorom nie był to proces ciągłego wzrostu zapotrzebowania na RAM, lecz bardziej sinusoida.

Już w 2012 roku postawiłem na stację roboczą z aż 32 GB pamięci RAM (DDR3, Kingston) i pamięć tę wykorzystywałem do cna. „Umiejętności” Chrome'a czy pakietu Adobe w pożeraniu RAM-u były w tym czasie niemal nieograniczone. Przy niedopracowanym Windowsie, nieustannych wyciekach pamięci z aplikacji i niekończących się błędach, nie wyobrażałem sobie pracy na komputerze z mniejszą ilością pamięci RAM niż 32 GB, no może 16 GB z ograniczeniami. Tymczasem rynek, zamiast pchać postęp w stronę ogromnych pojemności, niespodziewanie utknął na długo na 8 GB, pod które były optymalizowane gry, a w przypadku komputerów biurowych bardzo długo 4 GB RAM nie było wstydem, lecz „rozsądną oszczędnością”.

Dość powiedzieć, że 4 GB RAM były u Apple'a opcją startową do aż 2016 roku! Z kolei na przeskok z 8 GB RAM na 16 GB w podstawowych konfiguracjach poczekaliśmy aż do 2024 roku. Ale i komputery PC zaczęły niespodziewanie dobrze radzić sobie przy mniejszych ilościach RAM-u, a konfiguracje z 8 GB pamięci RAM, ale z dyskami SSD i nowymi procesorami nie dawały powodów do narzekań nawet największym malkontentom.

Nawet gracze nie potrzebują aż tak dużo RAM-u

Pamiętam, jak bardzo dziwiłem się, że w rekomendowanych zestawach dla graczy widzę konfiguracje z 8 GB RAM, a potem z 16 GB RAM, sądząc, że co jak co, ale gry pożrą każdą ilość pamięci. Tymczasem 32 GB RAM jako opcja komfortowa, a nie przyszłościowy dodatek, to dla graczy wymysł bardzo świeży, bo dopiero z okolic 2023 roku. Przełom przyniosły gry o gigantycznych otwartych światach i ultra-wysokiej jakości teksturach, które przy maksymalnych ustawieniach potrafią same zużywać 12–16 GB pamięci operacyjnej.

Nowym benchmarkiem popychającym w stronę 32 GB stały się takie tytuły jak Cyberpunk 2077 (wersja Next-Gen i mody HD), Starfield (szczególnie przy chęci streamowania), Baldur’s Gate 3 (multiplayer + streaming to spokojnie nawet 28 GB) czy Call of Duty: Modern Warfare II, który choć sam potrzebował 12 GB to już z Discordem, przeglądarką i Warzone overlay na 16 GB się dusił.

W 2025 roku, jak wylicza redakcyjny kolega Damian Jaroszewski, dla gracza 16 GB RAM to absolutne minimum, 32 GB to komfort, a 64 GB RAM to luksus. Również Przemysław Banasiak, który przygotowuje co miesiąc polecane zestawy komputerowe na łamach Telepolis, 16 GB RAM zaproponował w październiku 2025 jedynie w konfiguracjach poniżej 3000 zł, a nawet najtańszy komputer za 915 zł ma te 16 GB RAM „przyzwoitości”. Jak widać, zmieniło się i „nową szesnastką” są teraz 32 GB RAM, z drugiej jednak strony dają one taki zapas, że sugerujemy je graczom nawet w zestawach za ponad 10 tys. zł.

Nic to jednak dziwnego, od wielu lat w świecie gamingu częściej to VRAM karty graficznej staje się wąskim gardłem cyfrowej rozrywki niż pamięć RAM.

Na komputerze pracuję, a nie gram, więc... RAM-u daję tyle, ile tylko płyta główna przyjmie

Używam na co dzień 3 komputerów. Pomimo żalu do platformy MacOS, został mi jeszcze MacBook Air z 16 GB RAM, którego trudno mi czymś zastąpić w terenie (szukam nieustannie alternatywy), jest zaskakująco potężny i wystarczający do niemal wszystkiego Asus NUC Pro z 32 GB pamięci RAM, no i jest ten potwór, na którym pracuje najczęściej...

Pozbierałem od kolegów z działu hardware nieużywane aktualnie w platformach testowych części i z pomocą Przemka Banasiaka powstała zaskakująco potężna stacja do eksperymentów z AI:

Płyta główna: MSI MEG Z690 UNIFY

RAM: Kingston FURY Renegade RGB DDR5 6400 BK C32 DC 96 GB

Karta graficzna: RTX 4090 OC 24 GB

SSD: GOODRAM IRDM PRO SLIM 4 TB

Zasilacz: Cooler Master X Silent MAX 1300 W

Obudowa: Fractal Meshify 3

Chłodzenie: Valkyrie Dragonfang 240 ARGB

Pasta termoprzewodząca: Endorfy Pactum 4

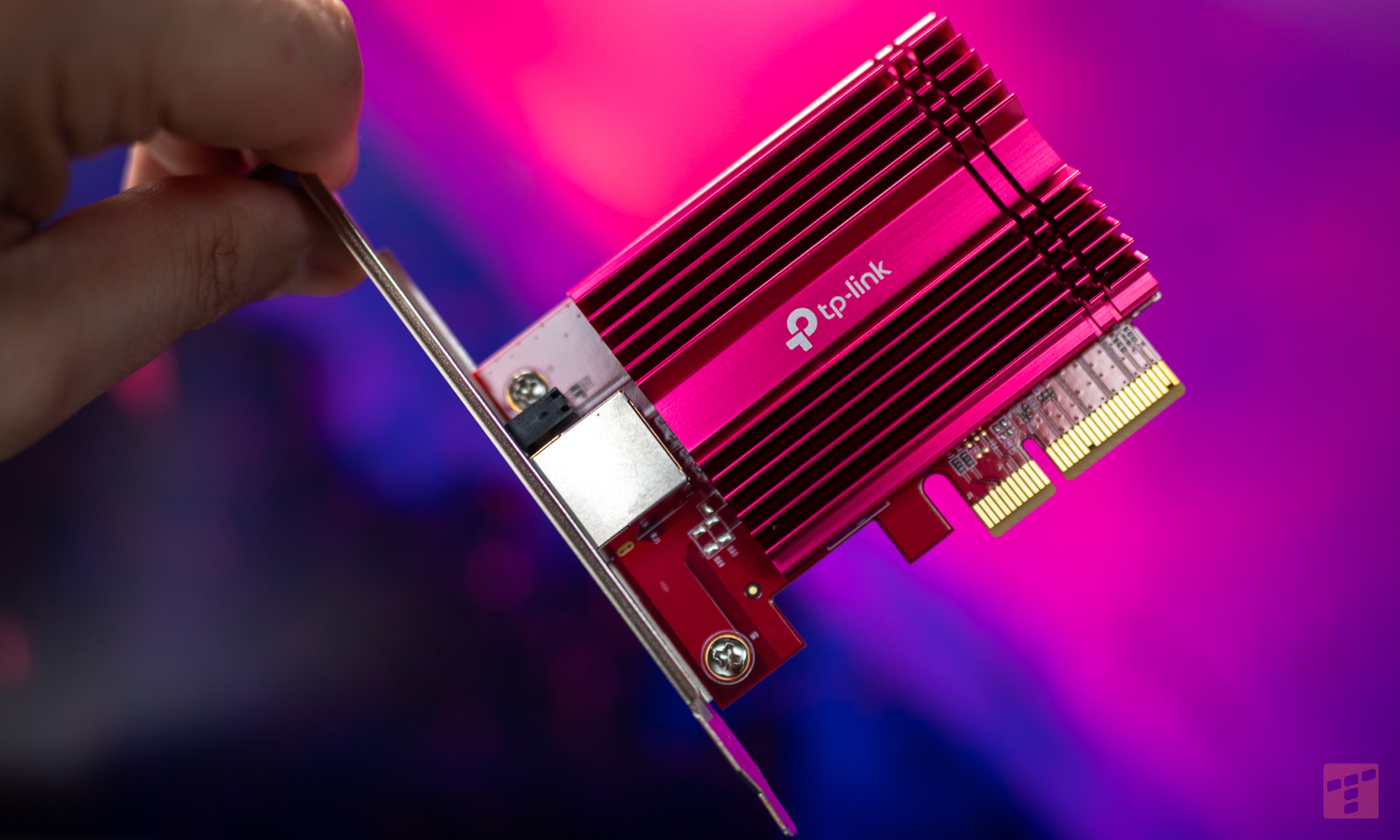

Karta sieciowa: TP-LINK TX401 10 Gbit (+ 2x 2,5 Gbit)

System operacyjny: Windows 11

Chociaż część wyborów, takich jak płyta czy procesor wynikało bezpośrednio z dostępności podzespołów w redakcji, to już pod kątem eksperymentów z AI potrzebowałem jak najwięcej i w dodatku jak najbardziej wydajnej pamięci. Przede wszystkim chodziło o pamięć VRAM karty graficznej, od której bezpośrednio zależą maksima wczytywanych modeli językowych, zarówno pełnych, jak i ich destylatów. Aż 24 GB VRAM topowego RTX-a poprzedniej generacji ledwo weszło w obudowę, ale było absurdalnie wręcz potężnym startem. Nieobsługiwane sprawnie modele to tylko nieliczne przypadki dla tej karty NVIDIA.

Do tego nawet 48 GB pamięci systemowej to by było za mało. Powód? Zajeżdżam ponad 40 GB w typowej pracy komputera, bez żonglowania modelami AI. No a ideą korzystania z modeli językowych nie jest u mnie zatrzymanie zupełnie pracy na komputerze, bo coś właśnie się generuje, tylko równoległa praca bieżąca i poszukiwanie pomocy w lokalnym AI.

Kingston FURY Renegade RGB DDR5 6400 BK C32 DC 96 GB to maksimum, jakie tylko mogła przyjąć płyta MSI MEG Z690 UNIFY, która przeżyła w naszej redakcji już swoje lata. Pewnie zmieściłbym się w 64 GB RAM w większości sytuacji, ale przy aktualnym wyścigu AI każdy zasób jest na wagę złota.

Do tego skusiłem się o dołożenie 10-gigabitowej karty Ethernet TP-LINK TX401, bo chociaż wspomniany MEG oferuje dwa złącza Ethernet 2,5 Gbit, grzechem byłoby nie wykorzystać w pełni oferty Orange Światłowód 8 Gb/s. W przypadku nawet stacjonarnego generowania treści AI dobre połączenie z siecią jest potrzebne praktycznie każdego dnia. Tutaj dzieje się zbyt wiele i dziesiątki gigabajtów aktualizacji czy nowych modeli muszą mieć dla siebie tunel bez ograniczeń.

Mijają miesiące gonienia króliczka, a chmura jest nadal górą

Nie mam wątpliwości, że na potrzeby lokalnego przetwarzania AI współczesna elektronika będzie wymagała tylko więcej i więcej pamięci RAM. Podwajanie wymaganych pojemności szybko wejdzie wszystkim w krew, na co producenci modułów zacierają już ręce. Nawet Apple ugiął się i dał do iPhone'a 17 Pro niespodziewanie 12 GB RAM, a jeszcze nie tak dawno temu 6 GB było wystarczające do wszystkiego. Bez większej ilości pamięci niektóre, z pozoru proste funkcje AI staną się niedostępne. Ssanie na RAM zaczynają mieć ze względu na funkcje AI również kolejne gry, a pewnie już za chwilę nie włączymy zwykłego edytora tekstu bez odpalenia uczenia maszynowego.

Eksperymenty z modelami językowymi z jednej strony przynoszą dużo wiedzy i frajdy, z drugiej zaś nie da się oprzeć wrażeniu, że coraz doskonalsze destylaty nie nadążają za wielkoskalowymi, multimodalnymi (przetwarzającymi różne rodzaje danych w tym samym czasie) modelami Big Techów. Cóż z tego, że kosztem szumu wentylatora przetworzę zdjęcia czy dokumenty, bez wysyłania ich do chmury i ryzykowania prywatnością, gdy efekt z najlepszych lokalnych modeli daleki jest do tego z najnowszych wersji ChatGPT czy Gemini. Gdy zaś użyjemy argumentu, że lokalnie nie ma cenzury, wpada niczym jeździec apokalipsy Elon Musk i zabiera swojemu Grokowi ostatnie hamulce poprawności.

Niezmiennie uważam jednak, że to lokalnie uruchamiane modele AI odegrają kluczową rolę w przyszłości rozwoju AI. Będą to wyspecjalizowane małe modele, które nie wydrenują nam akumulatorów w telefonach czy nie podwoją rachunków za prąd (w przeciwieństwie do tego pudła u mnie), a jednocześnie odciążą nas w codziennych czynnościach, nawet gdyby nagle przestał działać internet.

Coraz większe wątpliwości niesie też polityka prywatności Big Techów. Już od grudnia Meta (Facebook, WhatsApp, Messegner i inne usługi) bez prawa sprzeciwu zamierza przetwarzać zapytania użytkowników do celów komercyjnych. A to dopiero początek.

Wizja prywatnego, grzecznego AI uruchomionego w domu z miesiąca na miesiąc stawać będzie się coraz bardziej kusząca. Czymś takim może okazać się w charakterze inteligentnego procesora tekstu nasz rodzimy PLLuM, któremu do płynnej pracy wystarczy podstawowy laptop z grafiką Nvidia. Jestem zachwycony jego polszczyzną i dynamicznym rozwojem, a także — przynajmniej póki co — etycznymi założeniami.