Gemma to lekki, otwarty model Google AI

Google wprowadza lekki, otwarty model sztucznej inteligencji o nazwie Gemma. Narzędzie to zostało przygotowane w oparciu o te same technologie, co Gemini.

Gemma to rodzina lekkich, nowoczesnych, otwartych modeli sztucznej inteligencji (AI), zbudowanych w oparciu o te same badania i technologie, które wykorzystano przy tworzeniu modeli Gemini. Opracowana przez Google DeepMind i inne zespoły Google'a, Gemma jest inspirowana Gemini, a nazwa odzwierciedla łacińskie "gemma", oznaczające "kamień szlachetny". Gigant z Mountain View udostępnił przy okazji również narzędzia wspierające innowacje programistów, wspierające współpracę i odpowiedzialne korzystanie z modeli Gemma.

Gemma jest od dziś dostępna na całym świecie. Oto najważniejsze informacje na temat nowego modelu Google AI:

- Google wypuścił Gemmę w dwóch rozmiarach: Gemma 2B i Gemma 7B. Każdy rozmiar jest wydawany z wstępnie przeszkolonymi i dostrojonymi do instrukcji wariantami.

- Nowy zestaw narzędzi do odpowiedzialnej generatywnej sztucznej inteligencji zawiera wskazówki i niezbędne narzędzia do tworzenia bezpieczniejszych aplikacji AI z Gemmą.

- Google udostępnił łańcuchy narzędzi do wnioskowania i nadzorowanego dostrajania (SFT) we wszystkich głównych strukturach: JAX, PyTorch i TensorFlow, za pośrednictwem natywnego Keras 3.0.

- Rozpoczęcie pracy z Gemmą ułatwiają gotowe do użycia notebooki Colab i Kaggle, wraz z integracją z popularnymi narzędziami, takimi jak Hugging Face, MaxText, NVIDIA NeMo i TensorRT-LLM.

- Wstępnie wytrenowane i dostrojone do instrukcji modele Gemma mogą działać na laptopie, stacji roboczej lub Google Cloud, dzięki łatwemu wdrożeniu w Vertex AI i Google Kubernetes Engine (GKE).

- Optymalizacja na wielu platformach sprzętowych AI zapewnia wiodącą w branży wydajność, z uwzględnieniem procesorów graficznych NVIDIA i TPU Google Cloud.

- Warunki użytkowania zezwalają na komercyjne, odpowiedzialne wykorzystanie i dystrybucję dla wszystkich organizacji, niezależnie od wielkości.

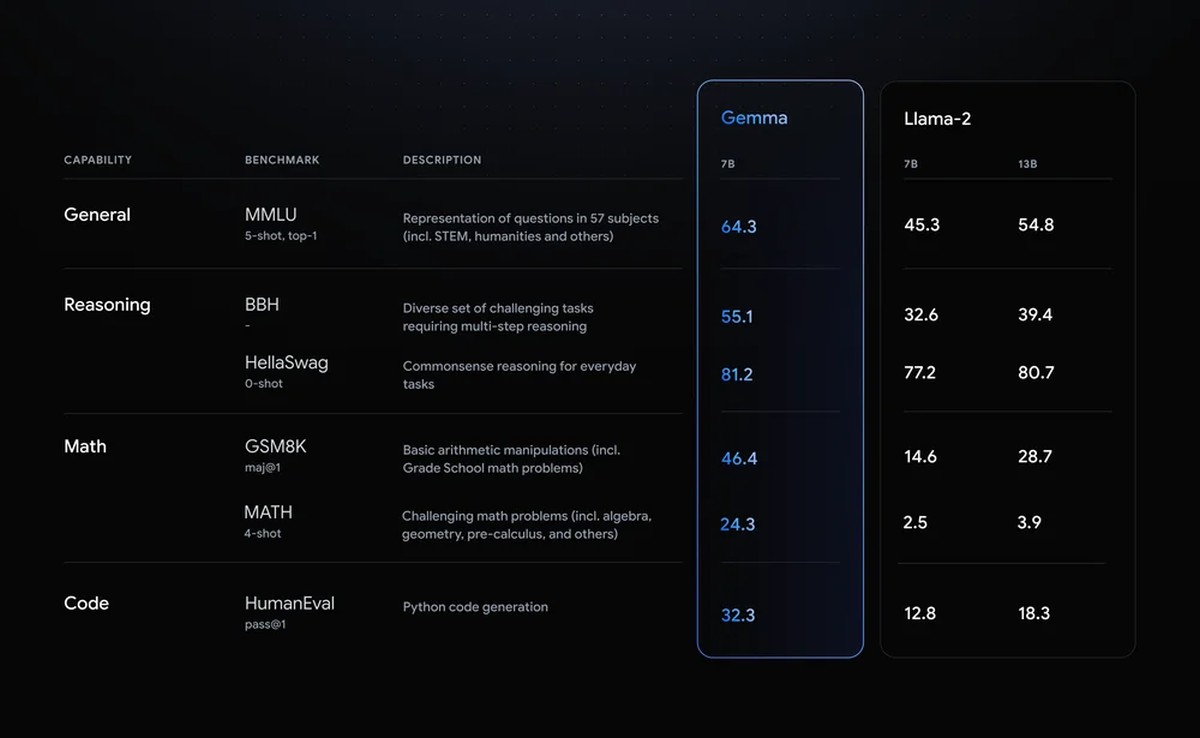

Wielka wydajność w małym rozmiarze

Modele Gemma współdzielą komponenty techniczne i infrastrukturalne z Gemini, największym i najbardziej wydajnym modelem sztucznej inteligencji firmy Google, dostępnym już na rynku. Jak zapewnia amerykański gigant, dzięki temu Gemma 2B i 7B osiągają najlepszą w swojej klasie wydajność. Modele Gemma mogą działać bezpośrednio na laptopie lub komputerze stacjonarnym dla programistów. Warto zauważyć, że Gemma przewyższa znacznie większe modele w kluczowych testach porównawczych, przestrzegając jednocześnie rygorystycznych standardów Goole'a, dotyczących bezpiecznych i odpowiedzialnych wyników.

Odpowiedzialność kluczem do sukcesu

Jak informuje firma Google, Gemma została zaprojektowana z myślą o zasadach tej firmy dotyczących sztucznej inteligencji. W ramach tworzenia wstępnie wytrenowanych modeli Gemma jako bezpiecznych i niezawodnych, Google zastosował zautomatyzowane techniki filtrowania niektórych danych osobowych i innych poufnych danych z zestawów treningowych. Ponadto zastosowano szeroko zakrojone dostrajanie i uczenie się przez wzmacnianie na podstawie informacji zwrotnych od ludzi (RLHF), aby dostosować modele do odpowiedzialnych zachowań. Aby zrozumieć i zmniejszyć profil ryzyka dla modeli Gemma, Amerykanie przeprowadzili solidne oceny, w tym ręczny red-teaming, zautomatyzowane testy przeciwstawne i oceny możliwości modelu pod kątem niebezpiecznych działań.

Wraz z Gemmą, Google udostępnia również nowy zestaw narzędzi do odpowiedzialnej generatywnej sztucznej inteligencji, co ma pomóc programistom i badaczom w ustalaniu priorytetów w tworzeniu bezpiecznych i odpowiedzialnych aplikacji AI. Zestaw narzędzi zawiera:

- Klasyfikacje bezpieczeństwa: nowatorska metodologia tworzenia solidnych klasyfikatorów bezpieczeństwa z minimalną liczbą przykładów,

- Debugowanie: narzędzie do debugowania modelu pomaga zbadać zachowanie Gemmy i rozwiązać potencjalne problemy,

- Kierowanie: można uzyskać dostęp do sprawdzonych metod tworzenia modeli opartych na doświadczeniu Google'a w tworzeniu i wdrażaniu dużych modeli językowych.

Optymalizacja pod kątem struktur, narzędzi i sprzętu

Modele Google Gemma można na podstawie własnych danych dostosować do określonych potrzeb aplikacji, takich jak podsumowanie lub generowanie rozszerzone o pobieranie (RAG). Gemma obsługuje szeroką gamę narzędzi i systemów:

- Narzędzia wieloplatformowe: można korzystać ze swojej ulubionej platformy z implementacjami referencyjnymi do wnioskowania i dostrajania: Keras 3.0, natywnych PyTorch, JAX i Hugging Face Transformers.

- Kompatybilność z różnymi urządzeniami: modele Gemma działają na popularnych typach urządzeń, w tym laptopach, komputerach stacjonarnych, IoT, urządzeniach mobilnych i w chmurze, umożliwiając szeroki dostęp do funkcji sztucznej inteligencji.

- Najnowocześniejsze platformy sprzętowe: Google nawiązał współpracę z firmą NVIDIA, aby zoptymalizować Gemmę pod kątem procesorów graficznych tego producenta, od centrów danych, przez chmurę, po lokalne komputery RTX AI, zapewniając wiodącą w branży wydajność i integrację z najnowocześniejszą technologią.

- Zoptymalizowany pod kątem Google Cloud: Vertex AI zapewnia szeroki zestaw narzędzi MLOps z szeregiem opcji dostrajania i wdrażaniem jednym kliknięciem przy użyciu wbudowanych optymalizacji wnioskowania. Zaawansowane dostosowywanie jest dostępne za pomocą w pełni zarządzanych narzędzi Vertex AI lub samodzielnie zarządzanego GKE, w tym wdrożenie w ekonomicznej infrastrukturze obejmującej procesory graficzne, TPU i procesory z dowolnej platformy.

Darmowe kredyty na badania i rozwój

Gemma została stworzona z myślą o otwartej społeczności programistów i badaczy, którzy napędzają innowacje w zakresie sztucznej inteligencji. Można rozpocząć współpracę z Gemmą już dziś, korzystając z bezpłatnego dostępu w Kaggle, bezpłatnej warstwy dla notebooków Colab i 300 USD kredytów dla początkujących użytkowników Google Cloud. Naukowcy mogą również ubiegać się o kredyty Google Cloud w wysokości do 500 tysięcy USD, aby przyspieszyć swoje projekty.

Więcej informacji można znaleźć na stronie ai.google.dev/gemma.