Google odpala Gemini 1.5. Tak wydajnie jeszcze nie było

Google ogłosił wydanie inteligentnego modelu nowej generacji, Gemini 1.5. W swojej najmocniejszej wersji ma on pokonać całą konkurencję, pokazując jej miejsce w szeregu.

Gemini 1.5 zapewnia znacznie zwiększoną wydajność. Stanowi to skokową zmianę w naszym podejściu, opierając się na badaniach i innowacjach inżynieryjnych w niemal każdym aspekcie rozwoju naszego modelu podstawowego i infrastruktury. Obejmuje to zwiększenie wydajności Gemini 1.5 w szkoleniu i obsłudze, dzięki nowej architekturze Mix-of-Experts (MoE).

– napisał Demis Hassabis, dyrektor generalny Google DeepMind

Pierwszym modelem Gemini 1.5, który gigant z Mountain View udostępnia do testów, jest Gemini 1.5 Pro. Jest to średniej wielkości model multimodalny, zoptymalizowany pod kątem skalowania w szerokim zakresie zadań i działający na podobnym poziomie do Gemini 1.0 Ultra, największego modelu Google'a do tej pory. Wprowadza również przełomową funkcję eksperymentalną w rozumieniu długiego kontekstu.

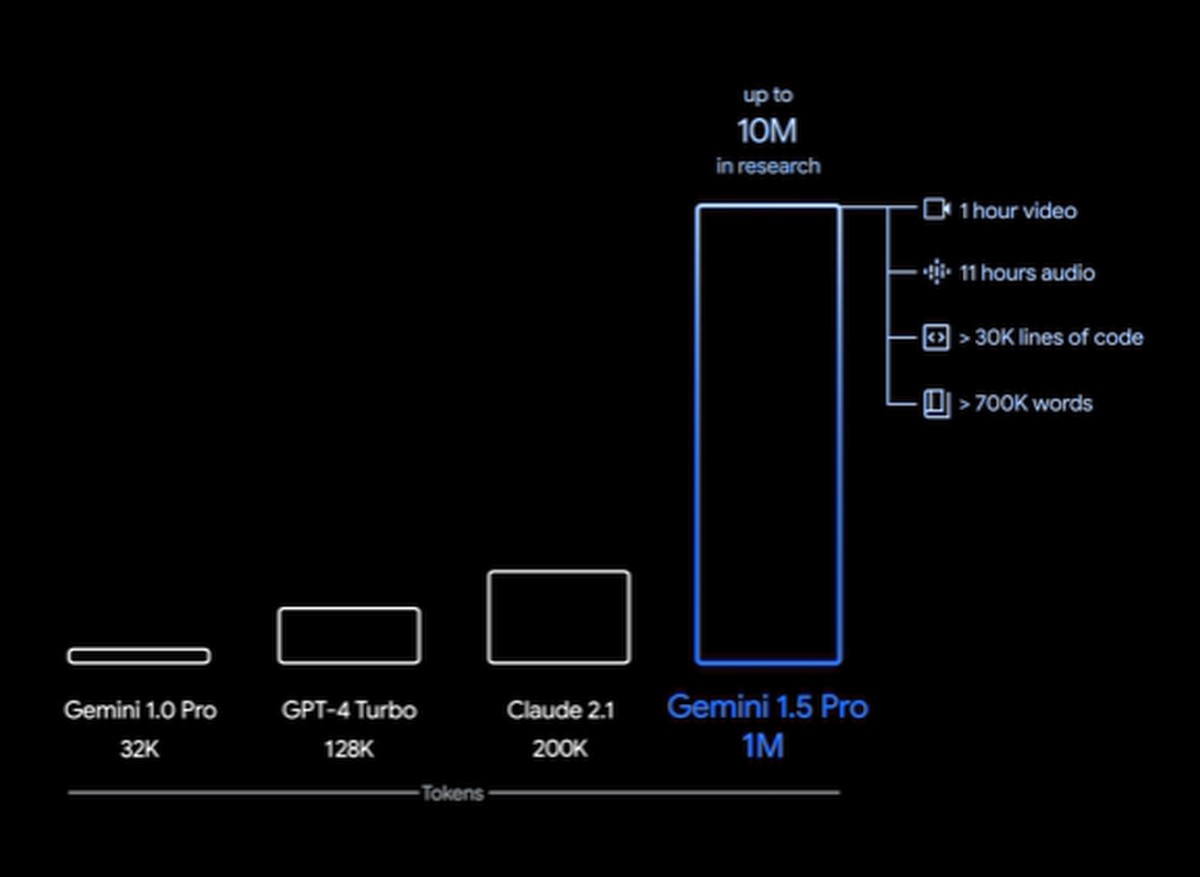

Gemini 1.5 Pro jest wyposażony w standardowe okno kontekstowe 128000 tokenów. Jednak ograniczona grupa deweloperów i klientów korporacyjnych może wypróbować ją w oknie kontekstowym do 1 miliona tokenów, co jest możliwe za pośrednictwem AI Studio i Vertex AI w prywatnej wersji zapoznawczej. W miarę wdrażania pełnego okna kontekstowego 1 miliona tokenów, Google intensywnie pracuje nad optymalizacjami, które mają doprowadzić do zmniejszenia opóźnień, zmniejszenia wymagań obliczeniowych i poprawy środowiska użytkownika.

Kluczowe możliwości Gemini 1.5

- Wysoce wydajna architektura. Zbudowany w oparciu o wiodące badania Google'a nad architekturą transformatorów i MoE, Gemini 1.5 szybciej się uczy złożonych zadań, jest też wydajniejszy w szkoleniu i obsłudze.

- Szerszy kontekst, bardziej przydatne możliwości. "Okno kontekstowe" modelu sztucznej inteligencji Gemini 1.5 mocno się zwiększyło w porównaniu z 32000 tokenów dla Gemini 1.0. Można teraz uruchomić ich aż do 1 miliona. Oznacza to, że 1.5 Pro może przetwarzać ogromne ilości informacji za jednym razem, w tym 1 godzinę wideo, 11 godzin dźwięku, ponad 30000 linii kodu lub ponad 700000 słów. W swoich badaniach Google z powodzeniem przetestował również opcję do 10 milionów tokenów.

- Złożone rozumowanie na temat ogromnych ilości informacji. Gemini 1.5 Pro może analizować, klasyfikować i podsumowywać duże ilości treści w ramach danego monitu. Na przykład, gdy otrzyma 402-stronicowe transkrypcje z misji Apollo 11 na Księżyc, może wnioskować o rozmowach, wydarzeniach i szczegółach znalezionych w całym dokumencie.

- Lepsze rozumienie w różnych modalnościach. Gemini 1.5 Pro może wykonywać wysoce wyrafinowane zadania związane ze zrozumieniem różnych modalności, w tym wideo. Na przykład, gdy otrzyma 44-minutowy niemy film Bustera Keatona, model może dokładnie przeanalizować różne punkty fabuły i wydarzenia, a nawet wywnioskować drobne szczegóły w filmie, które można łatwo przeoczyć.

- Odpowiednie rozwiązywanie problemów za pomocą dłuższych bloków kodu. Gemini 1.5 Pro może wykonywać bardziej istotne zadania związane z rozwiązywaniem problemów w dłuższych blokach kodu. Po otrzymaniu monitu zawierającego ponad 100000 wierszy kodu może lepiej uzasadnić przykłady, zasugerować przydatne modyfikacje i podać wyjaśnienia dotyczące działania różnych części kodu.

- Zwiększona wydajność. Gemini 1.5 Pro przewyższa swojego poprzednika w większości testów porównawczych i utrzymuje wysoką wydajność nawet przy rozszerzonym oknie kontekstowym. Po otrzymaniu podręcznika gramatycznego dla Kalamanga, języka, którym posługuje się mniej niż 200 użytkowników na całym świecie, model uczy się tłumaczyć z angielskiego na Kalamang na podobnym poziomie, jak osoba ucząca się z tej samej treści.

Dostępność i cena

Ograniczona wersja zapoznawcza Gemini 1.5 Pro jest dostępna dla programistów i klientów korporacyjnych za pośrednictwem AI Studio i Vertex AI. Google planuje wprowadzić różne poziomy cenowe oparte na rozmiarze okna kontekstowego, a pierwsi testerzy będą mogli eksperymentować z oknem kontekstowym 1 miliona tokenów za darmo w okresie testowym.