Koreańczycy zaskakują. Tak pojemnych pamięci jeszcze nie było

SK hynix nie ma zamiaru zwalniać tempa z innowacjami. Koreańczycy chcą wysunąć się na prowadzenie jako dostawcy najlepszych pamięci dla akceleratorów AI.

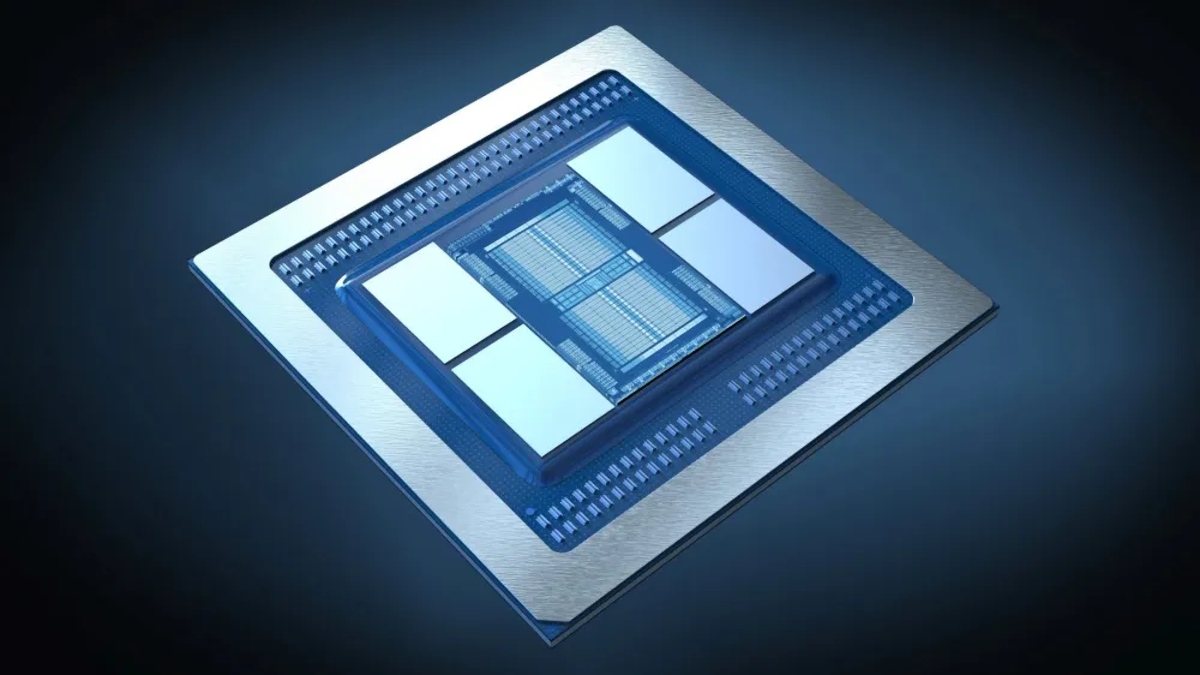

Osoby śledzące świat nowych technologii z pewnością zdają sobie sprawę z trwającego obecnie szaleństwa na sztuczną inteligencję. Firmy takie jak AMD, Intel czy NVIDIA prześcigają się w tym kto zaoferuje najwydajniejsze akceleratory AI, z których chcą korzystać giganci pokroju OpenAI, Facebooka i Google.

Zobaczymy wydajność do 1,22 TB/s per stos

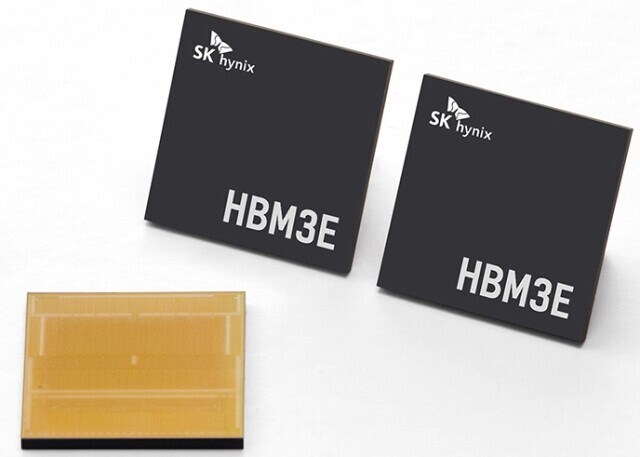

Układy dla centrów danych bazują na innych pamięciach niż rozwiązania konsumenckie. Zamiast GDDR używane są kości HBM. Oferują one bowiem większe pojemności i wyższe transfery. A tak się składa, że SK hynix chwali się nowym rozwiązaniem.

Koreańczycy zaprezentowali 12-warstwowe pamięci HBM3e o rekordowej pojemności 36 GB. Firma planuje dostarczyć masowo produkowane kości do partnerów w ciągu roku. To spore osiągnięcie, biorąc pod uwagę, że zaledwie w marcu debiutowały 8-warstwowe pamięci HBM3e.

Każda z warstw zapewnia wydajność na poziomie 9,6 GT/s, a więc szczytowa przepustowość modułu wynosi 1,22 TB/s. Tym samym akcelerator składający się z ośmiu stosów może zaoferować do 9,83 TB/s. Dodatkowo optymalizacje w procesie produkcji pozwoliły podobno na zapewnienie o 10% wyższej sprawności rozpraszania ciepła w porównaniu do poprzedniej generacji.