AMD ma asa w rękawie. Chodzi o sztuczną inteligencję

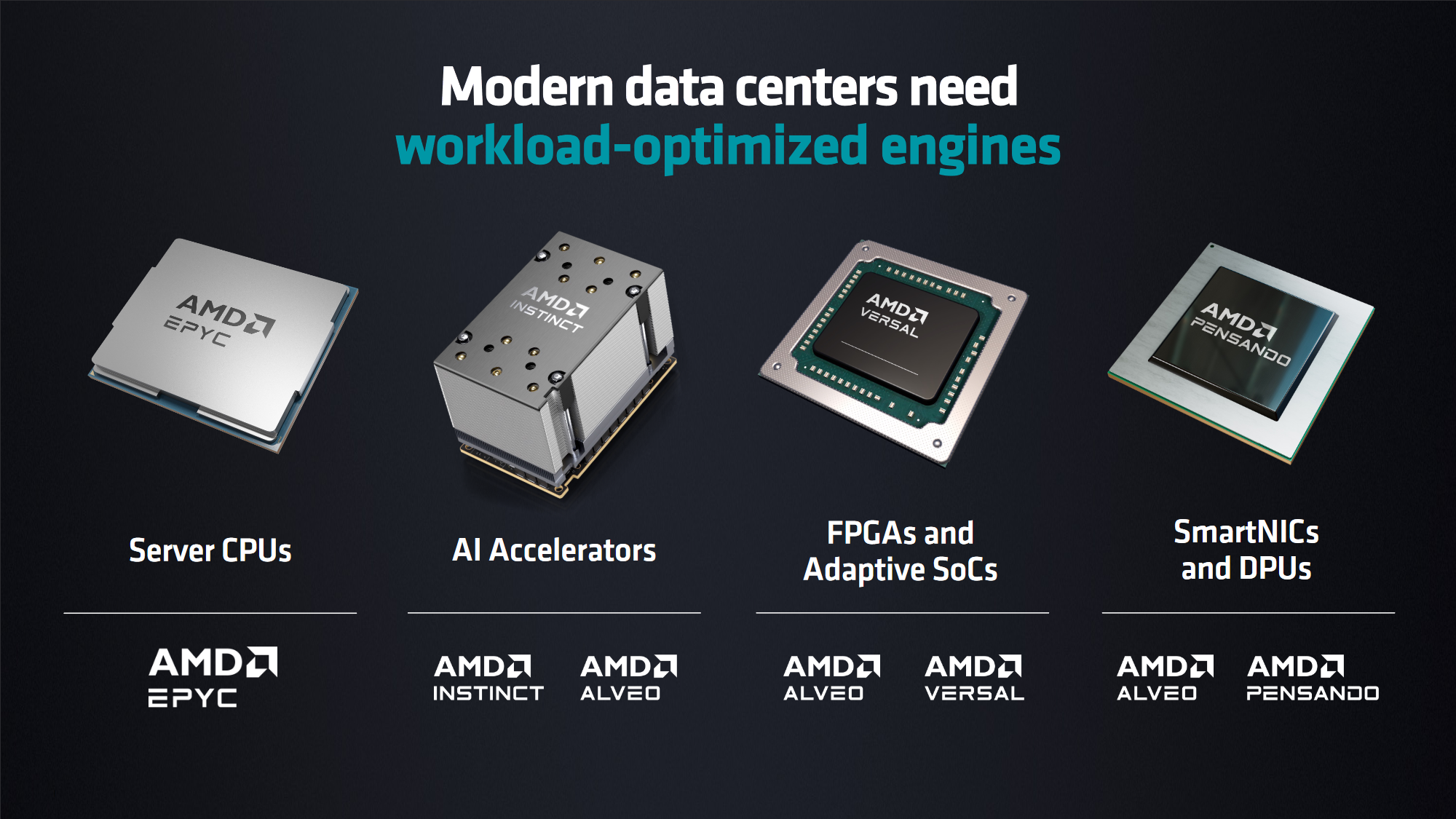

AMD nie zwalnia tempa. Czerwony gigant pokazał właśnie w San Francisco swoje najnowocześniejsze rozwiązania. Mowa o nowych procesorach EPYC dla centrów danych oraz akceleratorach Instinct dla AI.

Dzisiaj jest ważny dzień dla entuzjastów nowych technologii. Wszystko za sprawą AMD oraz ich wydarzenia odbywającego się w San Francisco, USA. Lisa Su wraz z innymi czołowymi przedstawicielami firmy oraz największymi partnerami zapowiada nowe procesory serwerowe, akceleratory AI oraz układy SoC, NIC i DPU.

AMD obiecuje nawet do 2,6x lepszą wydajność niż Intel

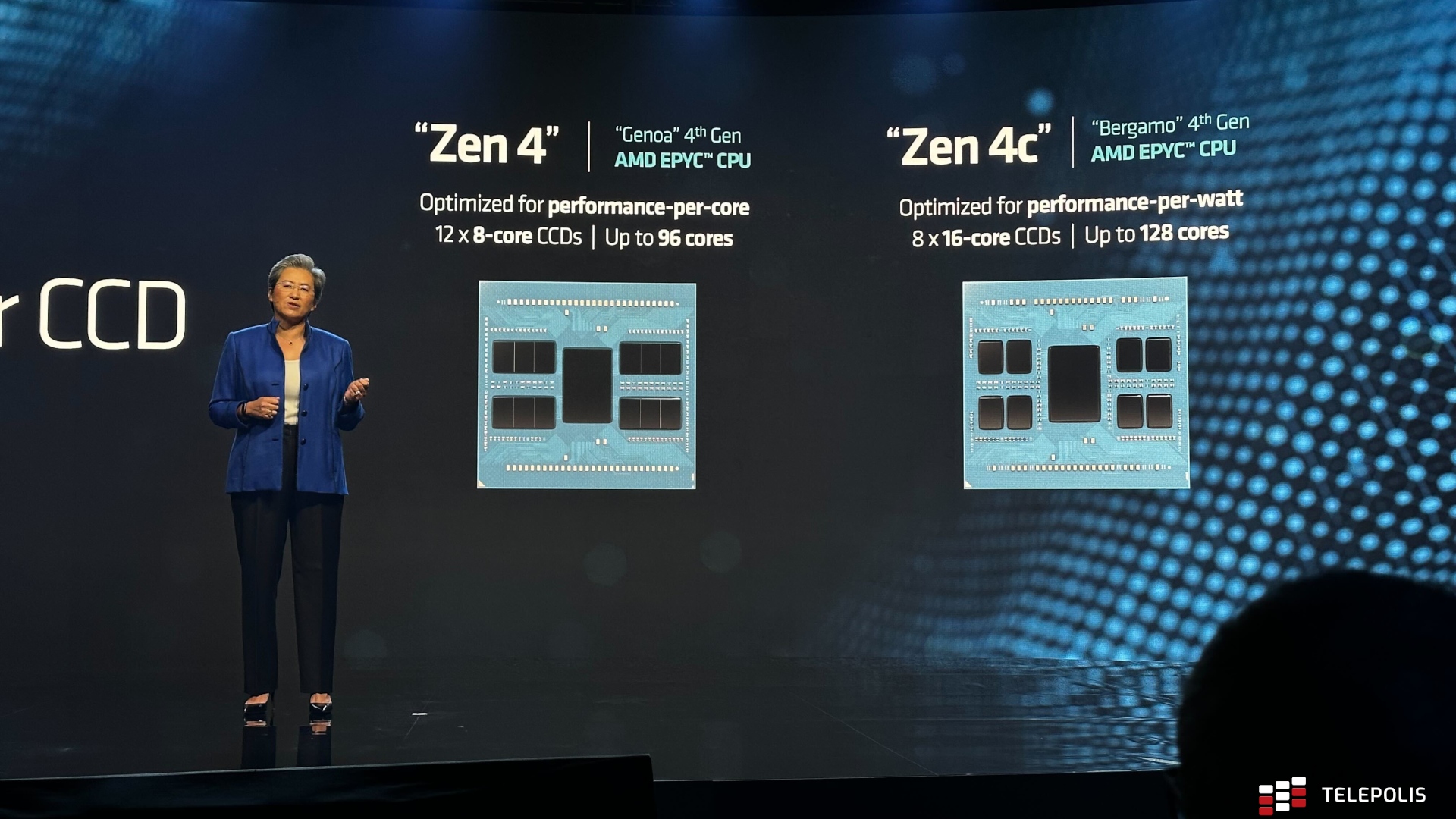

Oczywiście najciekawiej - nawet z punktu widzenia zwykłego śmiertelnika - prezentuje się rodzina AMD EPYC 4. generacji. Procesor AMD EPYC 9754 to przedstawiciel serii "Bergamo". Oferuje on do 128 rdzeni na bazie architektury AMD Zen 4c. Mowa o ośmiu CCD, każdy z nawet 16 rdzeniami na jednym kawałku krzemu. Całość wykonana w litografii 5 nm i z obsługą pamięci RAM DDR5 oraz interfejsu PCI Express 5.0.

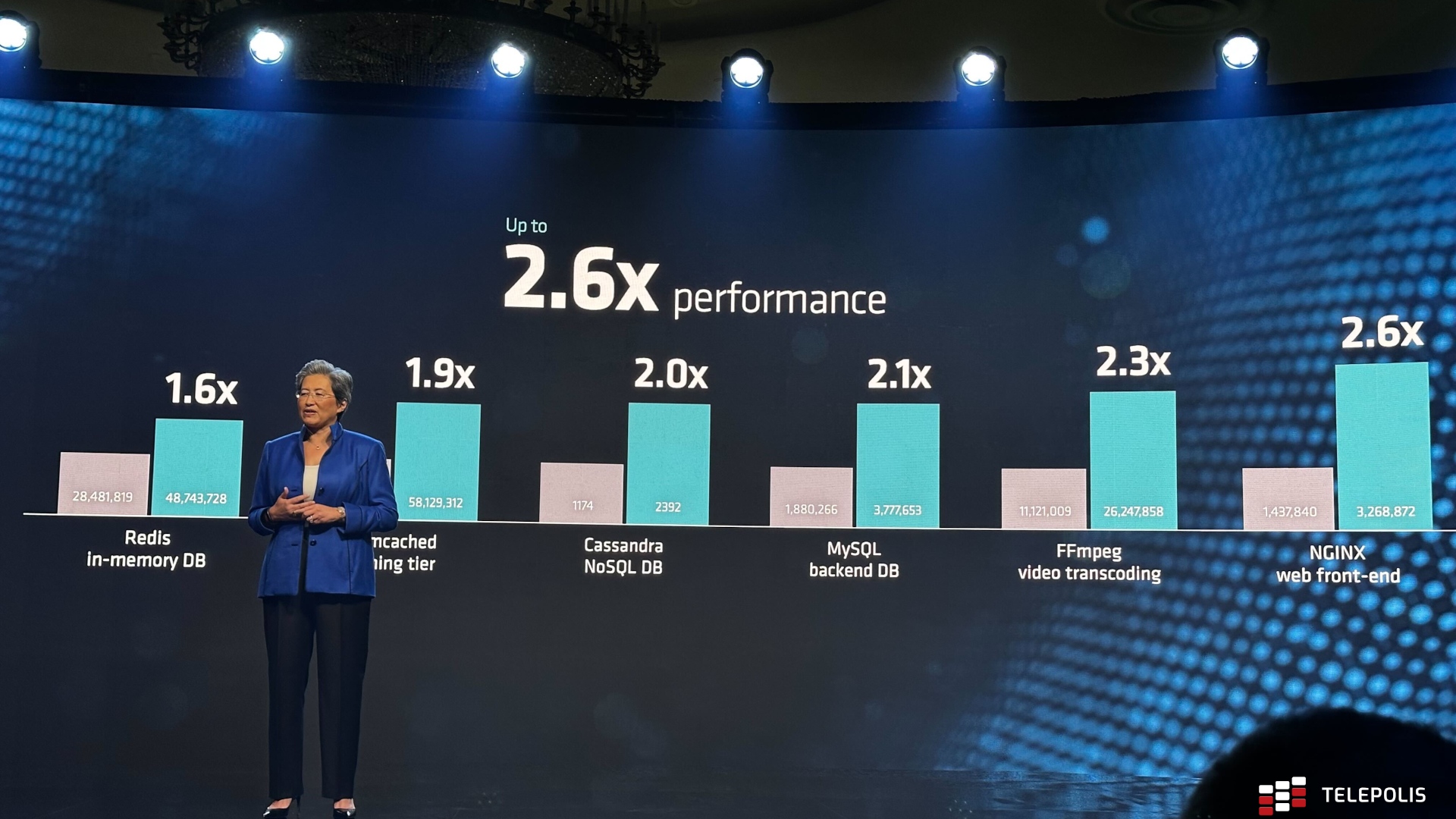

Skok wydajności w porównaniu do poprzedniej generacji oraz konkurencyjnych procesorów ma być ogromny i widoczny na pierwszy rzut oka. W przypadku zastosowań chmurowych AMD mówi o wynikach od 1,6x do nawet 2,6x lepszych. A wszystko to przy do 2,7x lepszej efektywności energetycznej. Nowe procesory Bergamo mają być dostępne dla pierwszych partnerów już od 3 kwartału 2023 roku.

Jednak to nie koniec nowości na rynku serwerowych CPU. AMD chwali się też procesorami AMD EPYC 4. generacji wyposażonymi w pamięć 3D V-Cache. W tym przypadku mowa nawet o 96 rdzeniach na bazie architektury AMD Zen 4, całość doprawiona ponad 1 GB pamięci podręcznej typu L3. Tutaj konstrukcja jest dużo bardziej skomplikowana.

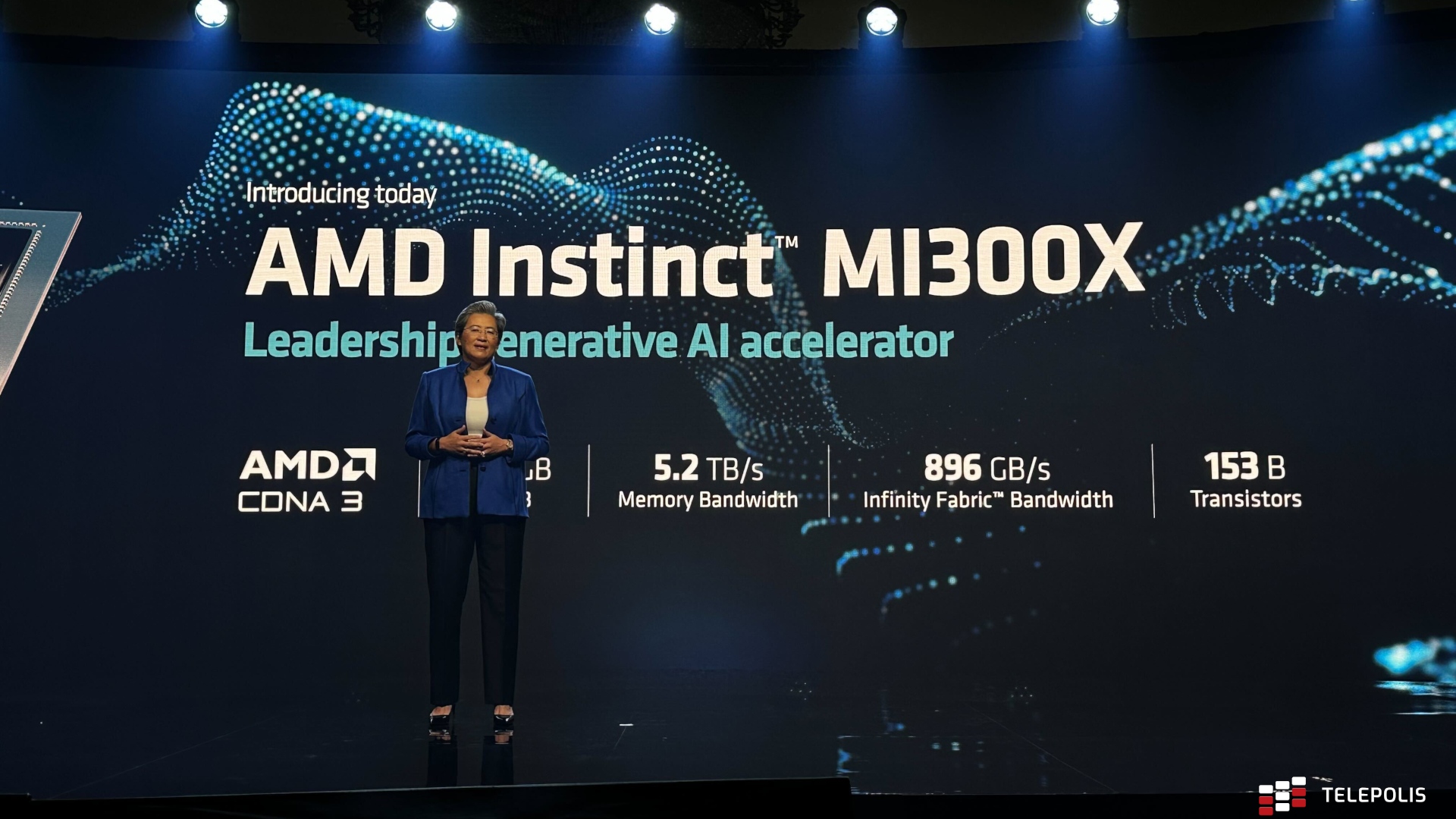

Oczywiście AMD, podobnie jak żadna inna firma, nie może przegapić potencjału związanego ze sztuczną inteligencją. Tutaj pomocne mają się okazać "najbardziej zaawansowane na świecie akceleratory AI". Mowa o układach AMD Instinct MI300X bazujących na architekturze AMD CDNA 3.

Mocną stroną jest szalenie pojemna i wydajna pamięć VRAM - do 192 GB w technologii HBM3. Pozwoli to na używanie nawet największych modeli takich jak Falcon-40B na zaledwie jednym akceleratorze. Chociaż warto zauważyć, że branża - z OpenAI - powoli odchodzi od ciągle rosnących modeli na rzecz lepszych metod treningu.

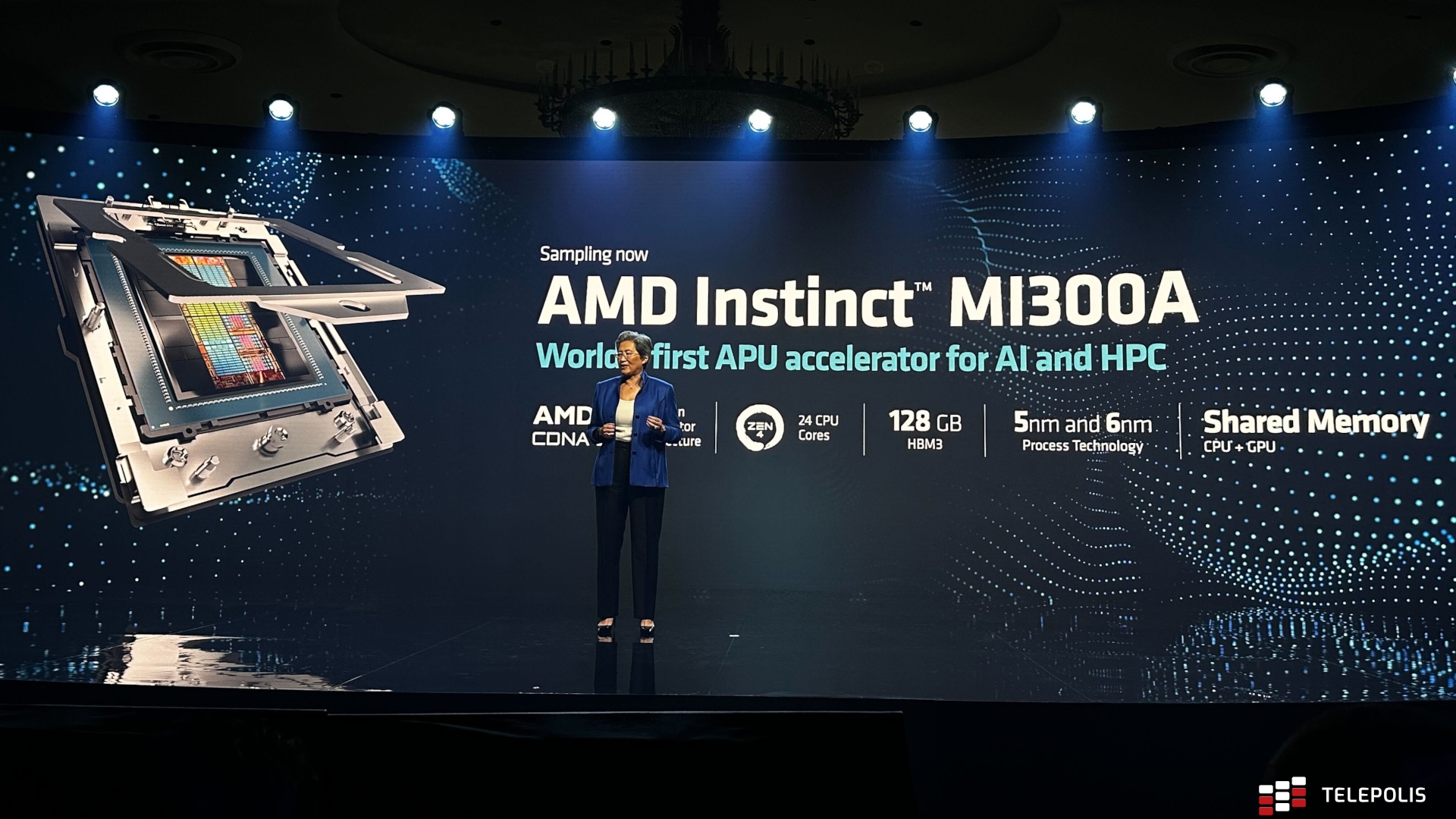

AMD Instinct MI300X zacznie trafiać do pierwszych partnerów już w trzecim kwartale. A już teraz dostępne są układy APU dla HPC i AI w postaci AMD Instinct MI300A. Co ważne Czerwoni nie zapominają również o warstwie software'owej, prezentując ekosystem AMD ROCm.

Jak zwykle w przypadku takich prezentacji - niezależnie o jakiej firmie mowa - z ostatecznymi ocenami warto wstrzymać się do niezależnych testów. Widać jednak, że giganci widzą potencjał w AMD. Na scenie bowiem nie zabrakło przedstawicieli firm takich jak Amazon, Meta, Microsoft czy Hugging Face.