To szaleństwo. Sam Altman zapowiada 100 milionów akceleratorów

Rynek sztucznej inteligencji zmienia się w zastraszającym tempie. Do rywalizacji potrzebne są już nie miliony, a dziesiątki i setki miliardów dolarów.

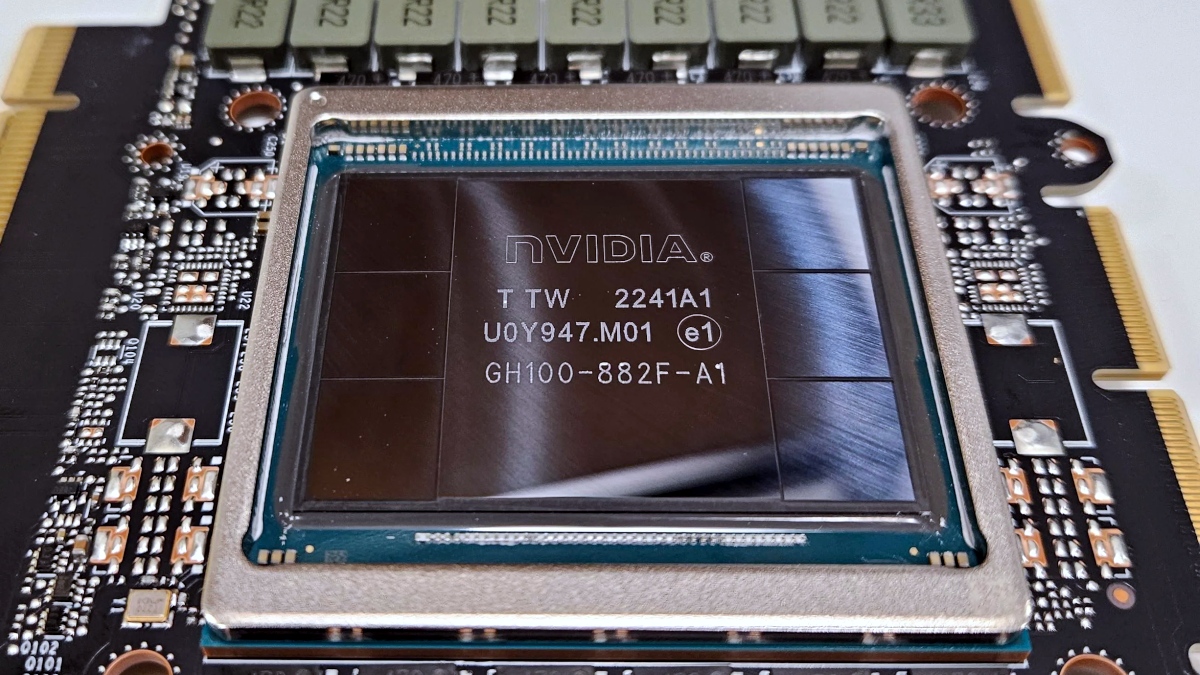

Sam Altman, dyrektor generalny OpenAI, ponownie zaskoczył branżę swoją najnowszą deklaracją. We wpisie na platformie X (daw. Twitter) możemy przeczytać, że jego firma jest na dobrej drodze, by do końca bieżącego roku wdrożyć znacznie ponad milion GPU. Dla porównania xAI należące do Elona Muska, które zdobyło uwagę mediów dzięki modelowi Grok 4, korzysta "tylko" z około 200 000 układów NVIDIA H100.

OpenAI chce zacząć korzystać też z chipów od innych firm

Co ciekawe twórcy ChatGPT twierdzą, że to wciąż zbyt mało. Sam Altman pochwalił swój zespół, ale zarazem stwierdził, iż zamiast spoczywać na laurach to powinni zacząć się zastanawiać jak pomnożyć wspomniany 1 milion akceleratorów AI "razy 100". To jednak brzmi już tak absurdalnie, że należy to traktować bardziej jak żart.

Koszt takiej operacji nie tylko sięgnąłby zawrotnych 3 bilionów dolarów (czyli niemal tyle co roczne PKB Wielkiej Byrtanii), ale również wiązałby się z ogromnym zapotrzebowaniem energetycznym. Do tego dochodzą też ograniczone moce produkcyjne NVIDII i partnerów jak TSMC.

we will cross well over 1 million GPUs brought online by the end of this year!

— Sam Altman (@sama) July 20, 2025

very proud of the team but now they better get to work figuring out how to 100x that lol

Już w lutym Altman przyznał, że OpenAI musiało opóźnić wdrażanie GPT‑4.5 z powodu... braku dostępnych GPU. Nie był to drobny problem, lecz poważny sygnał ostrzegawczy, zwłaszcza że flagowe układy NVIDII są już wyprzedane do przyszłego roku.

Od tego czasu skalowanie mocy obliczeniowej stało się dla OpenAI absolutnym priorytetem - firma zawiera strategiczne partnerstwa i realizuje projekty infrastrukturalne, które przypominają bardziej działania państwowe niż typową modernizację serwerowni.

OpenAI nie ogranicza się jednak do sprzętu od Zielonych. Choć główną bazą chmurową firmy pozostaje Microsoft Azure, przedsiębiorstwo współpracuje także z Oracle nad budową własnych centrów danych i według nieoficjalnych informacji rozważa wykorzystanie akceleratorów od Google, by zdywersyfikować swój stos obliczeniowy. To część szerszego wyścigu zbrojeń w branży, w którym także Meta i Amazon stawiają na rozwój własnych chipów AI i inwestują w pamięci HBM.

A więc czy 100 milionów GPU jest obecnie możliwe? Nie. Wymagałoby to rewolucji w produkcji, efektywności energetycznej i kosztach. Ale o to właśnie chodzi - Altman nie patrzy na to, co jest możliwe dziś, lecz na to, co będzie możliwe jutro. Milion akceleratorów w tym roku to nowy punkt odniesienia dla infrastruktury AI. A wszystko co nastąpi później, to już kwestia ambicji. I sądząc po dotychczasowych dokonaniach Altmana - lekceważenie tych ambicji może być poważnym błędem.