OpenAI kończy projektowanie własnego akceleratora AI

Czy to ostatnie lata rekordowych zysków NVIDII? Coraz więcej gigantów w świecie sztucznej inteligencji stawia na własne układy.

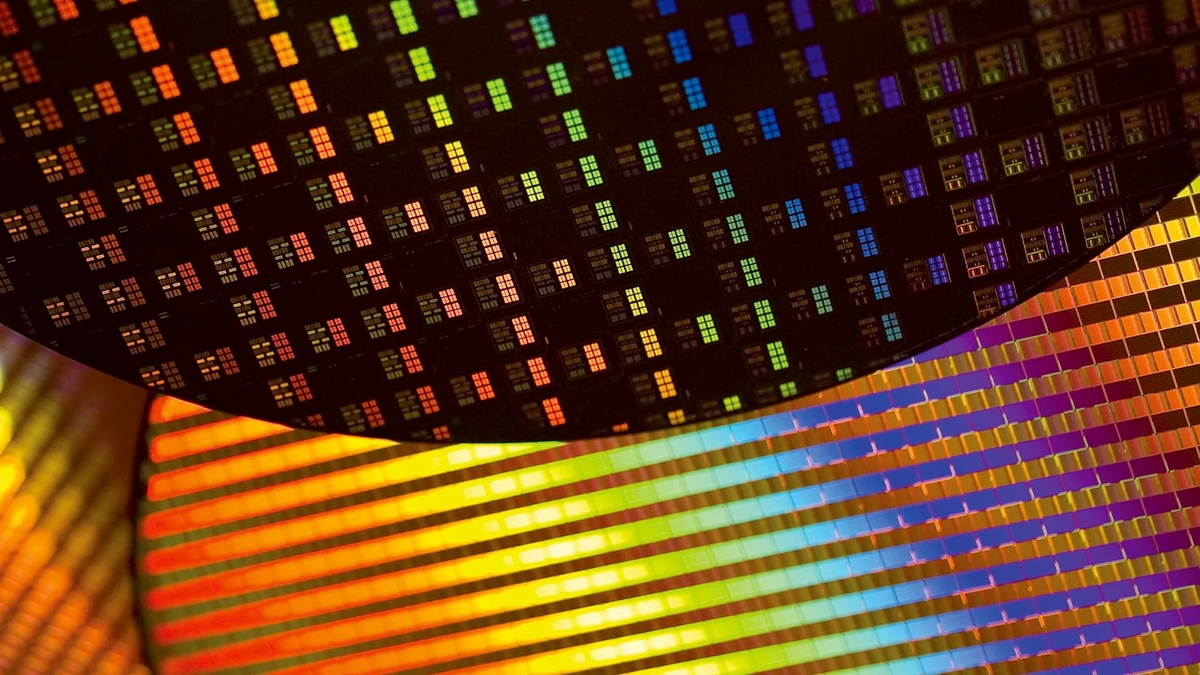

OpenAI, firma stojąca za popularnym ChatGPT, jest coraz bliżej zakończenia prac nad autorskim akceleratorem AI. Według najnowszych doniesień, projektowanie układu jest na ostatniej prostej i jego finalizacja zajmie jeszcze tylko kilka miesięcy. Jeśli wszystko pójdzie zgodnie z planem, OpenAI wyśle swój chip do TSMC w celu tzw. tape-outu już w pierwszej połowie roku.

OpenAI chce ograniczyć zależność od NVIDII

Proces ten, niezbędny do uruchomienia masowej produkcji, może potrwać około pół roku i będzie kosztował firmę miliony dolarów. Istnieje jednak możliwość, że jeśli OpenAI zdecyduje się zapłacić TSMC dodatkowo za priorytetyzację, to układy pojawią się szybciej. Trzeba jednocześnie pamiętać, że nie ma gwarancji sukcesu pierwszego tape-outu - w przypadku niepowodzenia konieczne byłoby ponowne przejście przez cały proces.

Już wcześniej pojawiały się doniesienia o współpracy OpenAI oraz TSMC, a tematem była litografia A16 i generator wideo Sora. Nie jest jednak pewne czy chodzi o tę samą konstrukcję, której projekt jest obecnie na finiszu, czy o zupełnie inny układ. Prace nad chipem prowadzi 40-osobowy zespół Richarda Ho, a całość powstaje we współpracy z firmą Broadcom.

Nazwa układu OpenAI nie jest jeszcze znana. Wiadomo natomiast, że zostanie on zoptymalizowany głównie pod kątem trenowania i uruchamiania modeli AI. Początkowo ma to być chip o ograniczonym zakresie zastosowań, jednak wszystko zależy od tego, ile egzemplarzy firma w przyszłości zdecyduje się wprowadzić na rynek.

Spekuluje się, że masowa produkcja mogłaby się rozpocząć już w 2026 roku. TSMC miałoby wówczas wykorzystać litografię 3 nm, a sam akcelerator mógłby zostać wyposażony w architekturę macierzy splotowych (tzw. systolic array) oraz pamięć HBM, podobnie jak najnowsze karty NVIDII dedykowane rozwiązaniom AI. To pozwoliłoby znacząco ograniczyć zależność od rozwiązań drużyny Jensena Huanga.