Palit GeForce RTX 4090 GameRock OC - test. Wywaliło mnie z butów

W końcu nadszedł ten czas. W sklepach pojawiły się karty graficzne GeForce RTX 4090, czyli pierwsze modele nowej generacji. Jednym z nich jest Palit GeForce RTX 4090 GameRock OC, którego przetestowałem. To prawdziwe monstrum!

Ponad 2 lata gracze musieli czekać na premierę nowej generacji kart graficznych GeForce RTX. W tym czasie rynek przeszedł liczne zawirowania i przez wiele miesięcy dostępność GPU była mocna ograniczona, a ceny wywindowane do kosmicznych wręcz poziomów. Na szczęście seria RTX 40 debiutuje w momencie, gdy kryzys jest już za nami (chociaż szykują się inne, jak np. energetyczny). Na początek NVIDIA serwuje nam najmocniejsze modele GeForce RTX 4090, które skierowane są do największych entuzjastów z najbardziej zasobnymi portfelami.

Przed premiera nowej generacji docierały do nas różne informacje. Z jednej strony mówiło się o ogromnym wzroście wydajności, chociaż pojawiały się też doniesienia, według których w grach nie będzie on aż tak spektakularny. Nie brakowało też informacji o bardzo wysokim zapotrzebowaniu na prąd i TGP na poziomie nawet 600 W. Ostatecznie stanęło na 450 W, co nadal jest wartością wysoką (RTX 3090 miał TGP na poziomie 350 W) i to szczególnie w dobie kryzysu energetycznego i konieczności oszczędzania. Ale co z tą wydajnością? Miałem okazję przetestować przedpremierowo aż dwa modele GeForce RTX 4090. Jednym z nich jest wersja Palit GameRock OC, które test właśnie macie okazję czytać.

Specyfikacja Palit GeForce RTX 4090 GameRock OC

Specyfikacja kart graficznych GeForce RTX 4090 jest już znana. Są to modele wyposażone w układ AD102-300, który z kolei składa się z 76 mld tranzystorów oraz aż 16384 rdzeni CUDA. Referencyjne taktowanie w Boost wynosi 2520 MHz, ale w przypadku Palita zostało ono podniesione do 2610 MHz. Różnica niby niewielka, ale jednak pozwala uzyskać kilka dodatkowych klatek na sekundę. W parze z GPU idą 24 GB pamięci GDDR6X 21 Gbps, które przy 384-bitowej magistrali osiągają przepustowość na poziomie 1008 GB/s.

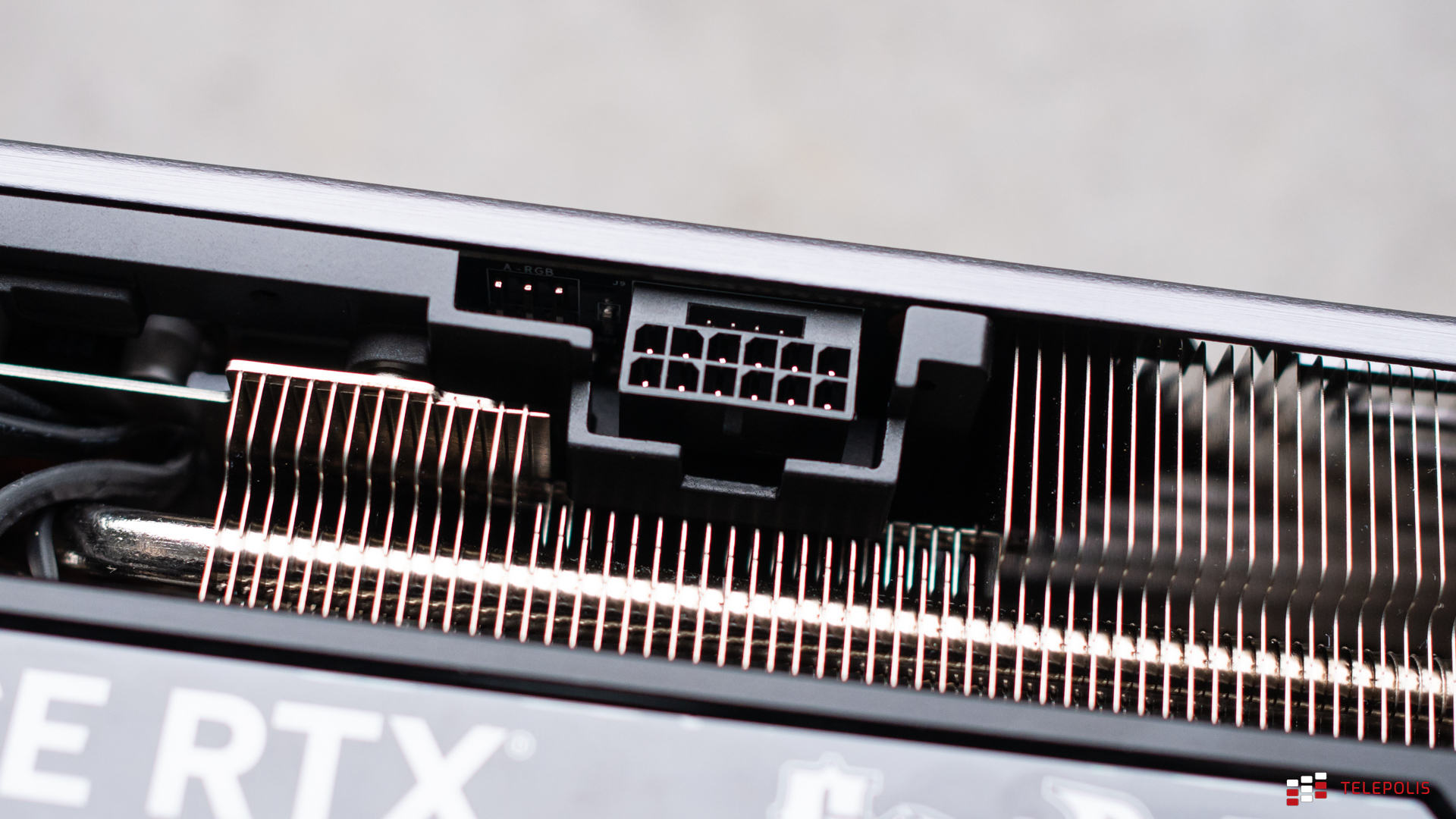

Deklarowana przez NVIDIĘ wydajność FP32 to 82,6 TFLOPS. Bazowe TGP to 450 W, ale autorskie modele mogą dobijać nawet do 660 W. Co ciekawe, Palit deklaruje moc karty na poziomie 450 W, ale jednocześnie rekomenduje zasilacz o mocy aż 1200 W. To prawdopodobnie spora przesada. Nasz platforma testowa wyposażona jest w PSU o mocy 850 W i nie miał on żadnych problemów z uciągnięciem RTX-a 4090 i to nawet przy pełnym obciążeniu. Nie oznacza to, że lepszym wyborem nie będzie mocniejszy zasilacz, aby mieć odpowiedni zapas mocy, szczególnie w przypadku mocniejszych procesorów. Karta zasilana jest za pomocą pojedynczego, 16-pinowego złącza Micro-Fit Molex, ale w zestawie znajduje się przejściówka z aż czterech 8-pinowych złączy PCIe.

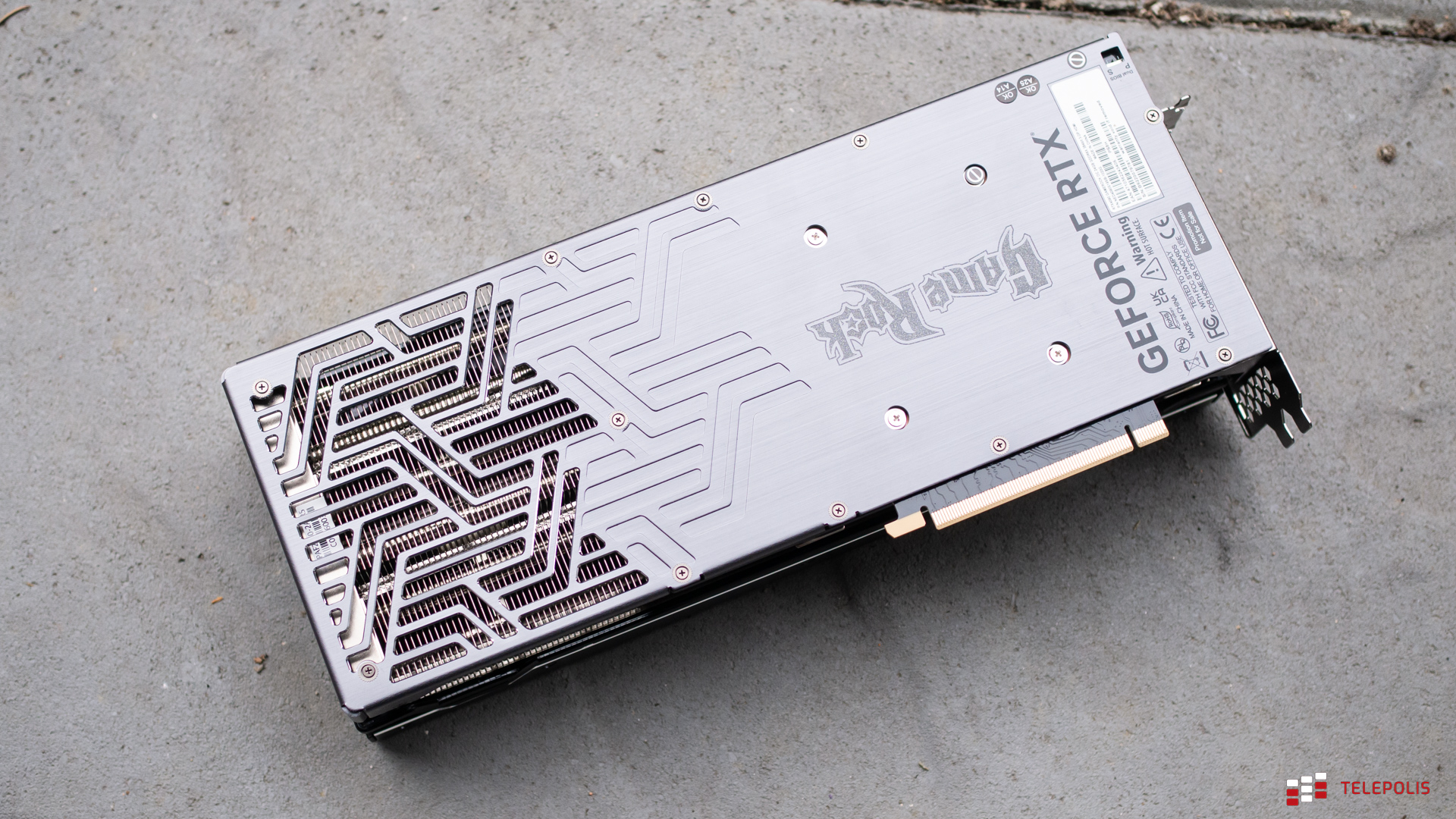

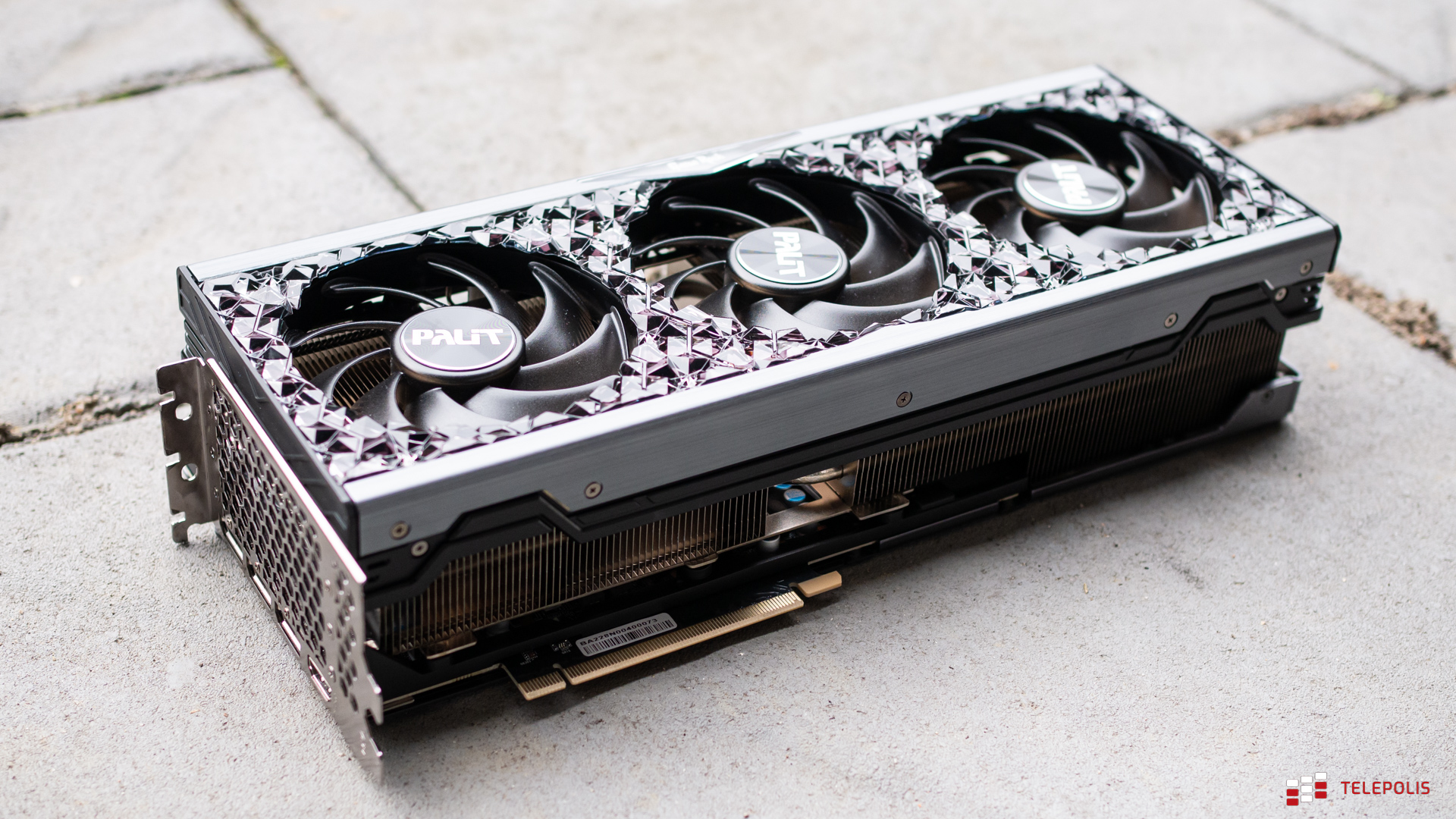

Uwagę zwraca też konstrukcja karty. System chłodzenia składa się z komory parowej, trzech wentylatorów z łopatkami Gale Talon, ciepłowodów o średnicy 6 i 8 mm oraz radiatora z finami w kształcie litery Y, dzięki czemu powietrze ma płynniej przez nie przechodzić i tym samym skuteczniej odprowadzać ciepło. Nie brakuje też metalowego backplate’u oraz podświetlenie ARGB, które dodatkowo potęgowane jest przez oryginalny design karty, przywodzący na myśl kamienie szlachetne. Karta ma wymiary 329,4 × 137,5 × 71,5 mm i zajmujesz aż 3,5 slota w obudowie komputera. Moja kuchenna waga wskazała też masę około 2 kg. To naprawdę potężna konstrukcja, więc nic dziwnego, że w pudełku znajduje się też płytka podtrzymująca, która ma uchronić kartę przed ewentualnym wygięciem. Karta została wyceniona na 9449 zł.

- Rdzeń: Lovelace AD102-300 (RTX 4090),

- Proces technologiczny: 4 nm (TSMC),

- Taktowanie GPU: 2235 MHz (bazowo), 2610 MHz (Boost)

- Pamięć: 24 GB GDDR6X 21 Gbps,

- Szyna pamięci: 384-bitowa,

- Przepustowość pamięci: 1008 GB/s,

- Jednostki CUDA: 16384,

- Jednostki RT: 128,

- Jednostki Tensor: 512,

- Jednostki ROP: 192,

- Interfejs: PCI-Express 4.0 x16,

- Złącza: 3 × DisplayPort 1.4a, 1 × HDMI 2.1,

- Zasilanie: 16-pinowa wtyczka Micro-Fit Molex (przejściówka z 4 × 8-pinowej),

- Wymiary: 329,4 × 137,5 × 71,5 mm (3,5 slota),

- Gwarancja: 24 miesiące,

- Cena: około 9449 zł.

Platforma testowa i metodologia

Naszą platformę testową poznaliście już w osobnym tekście. Nie powstałaby ona, gdyby nie nasi partnerzy – Intel, XPG, Asus, Palit oraz AOC, które zapewniły nam odpowiednie podzespoły, za co jeszcze raz bardzo dziękujemy.

Specyfikacja komputera, na którym testowane są wszystkie sprzęty komputerowe, prezentuje się następująco:

- Procesor: Intel Core i9-11900K

- Chłodzenie: XPG Levante 240

- Płyta główna: Asus ROG Maximus XIII Hero

- Pamięci RAM: XPG Spectrix D60G 32 GB (4 × 8 GB) DDR4 4133 MHz CL19

- Dysk: XPG GAMMIX S50 Lite SSD NVMe Gen4x4

- Zasilacz: XPG Core Reactor 850 Gold

- Obudowa: XPG Battlecruiser

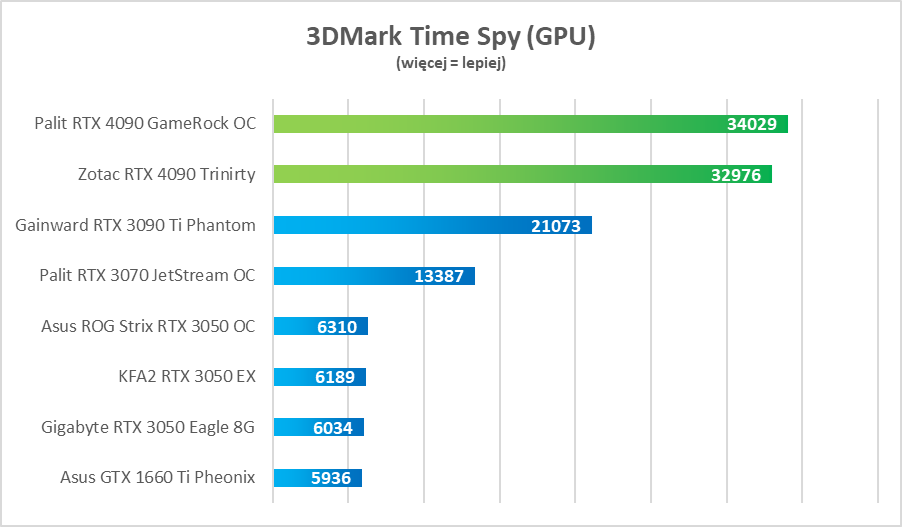

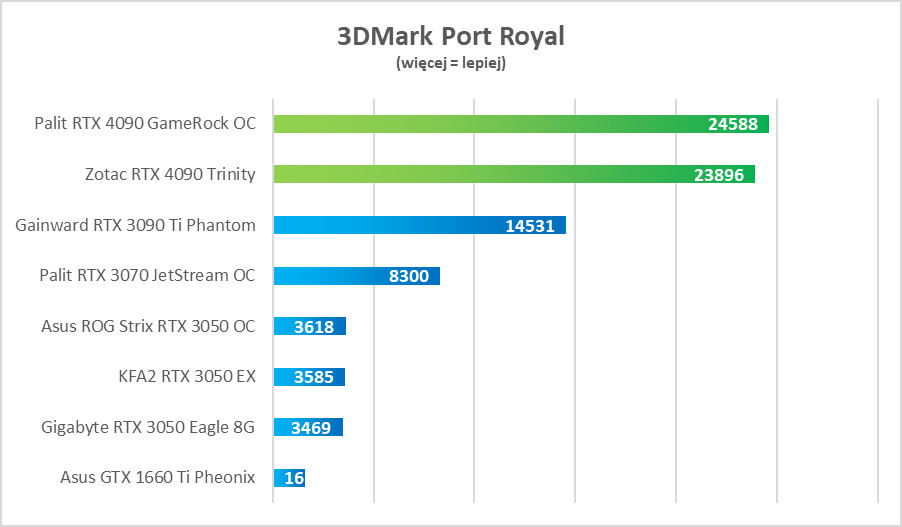

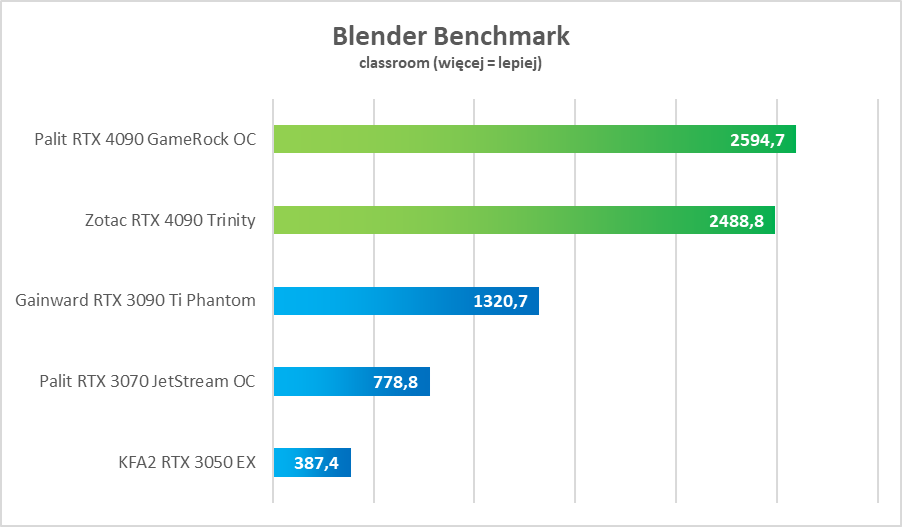

Jeśli chodzi o metodologię testowania kart graficznych, to do minimum ograniczyliśmy benchmarki, które może i pokazują różnice między poszczególnymi modelami, ale niewiele mówiąc o ich realnej wydajności. Dlatego na liście znajdują się tylko 3DMark Time Spy i Port Royal oraz Blender.

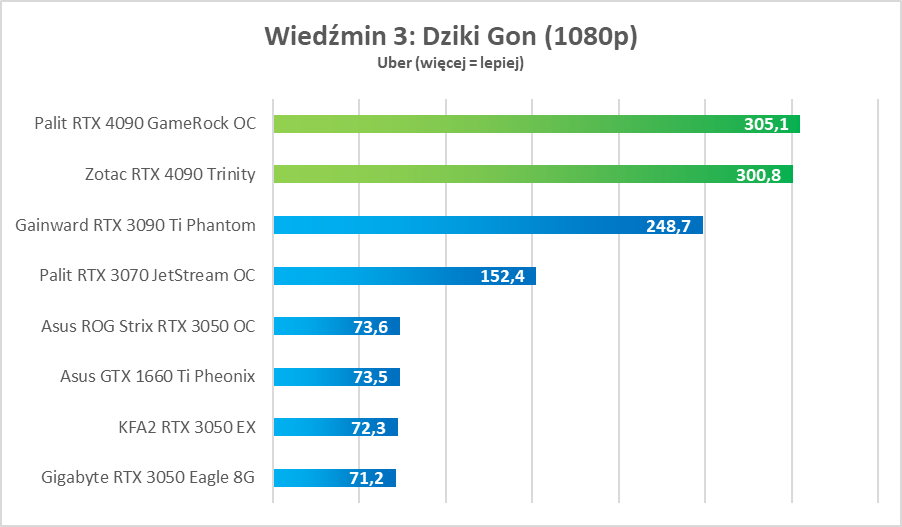

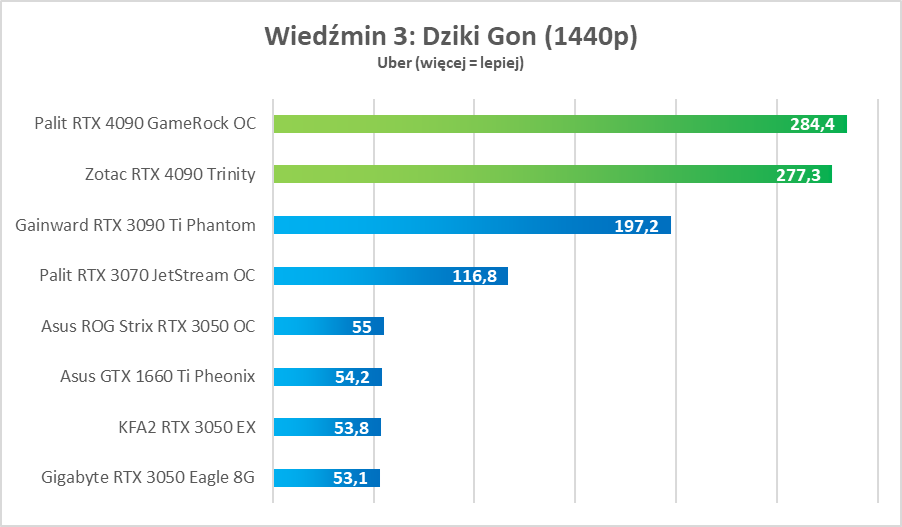

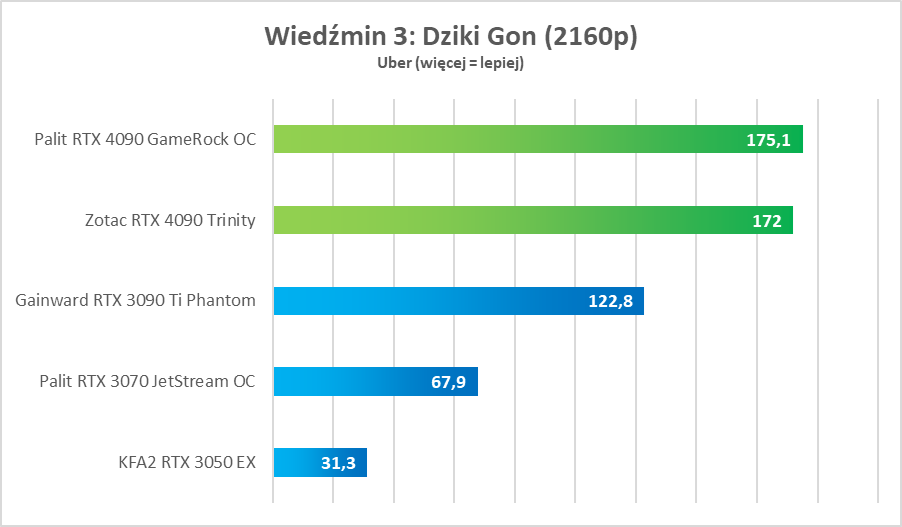

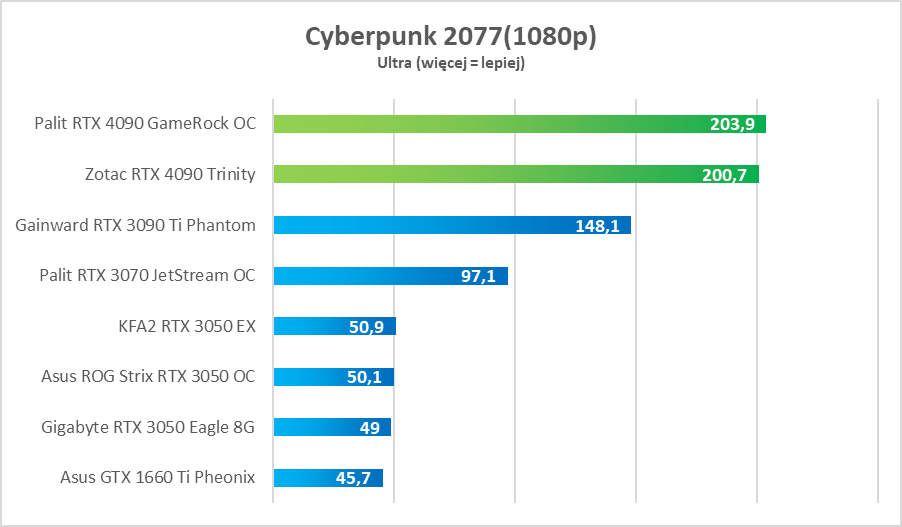

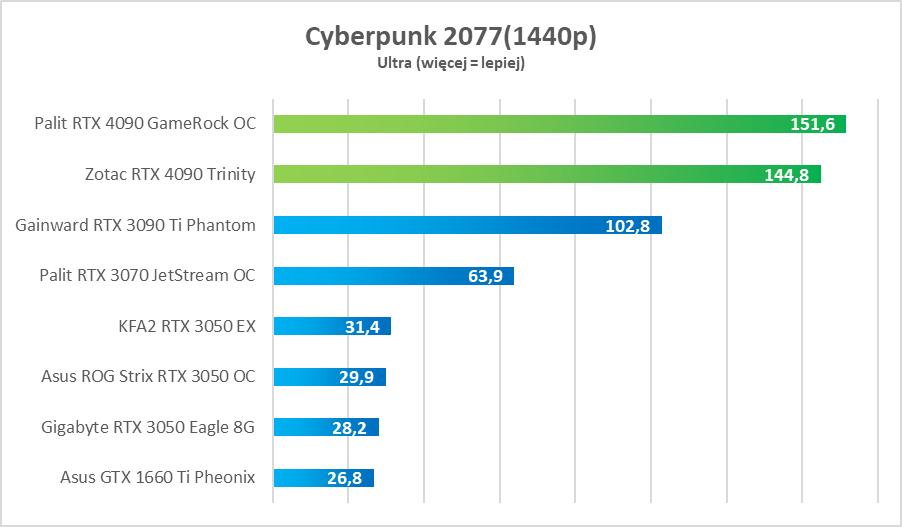

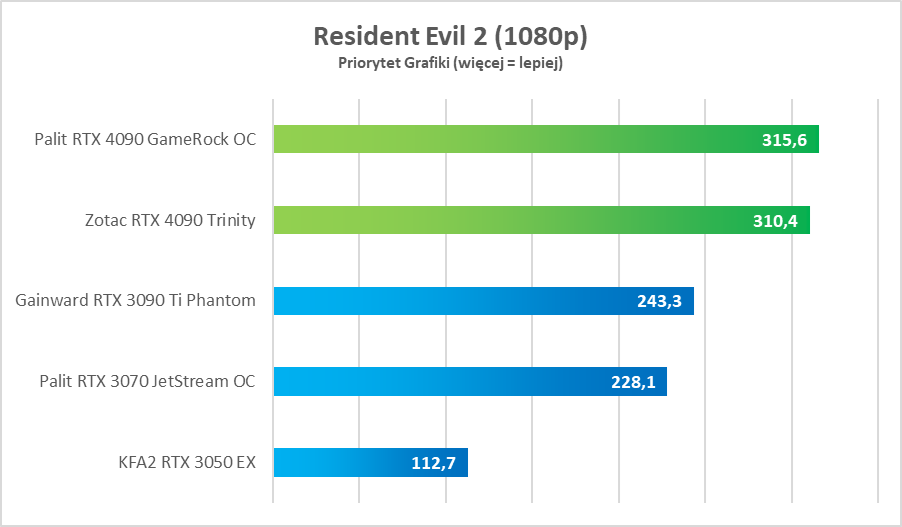

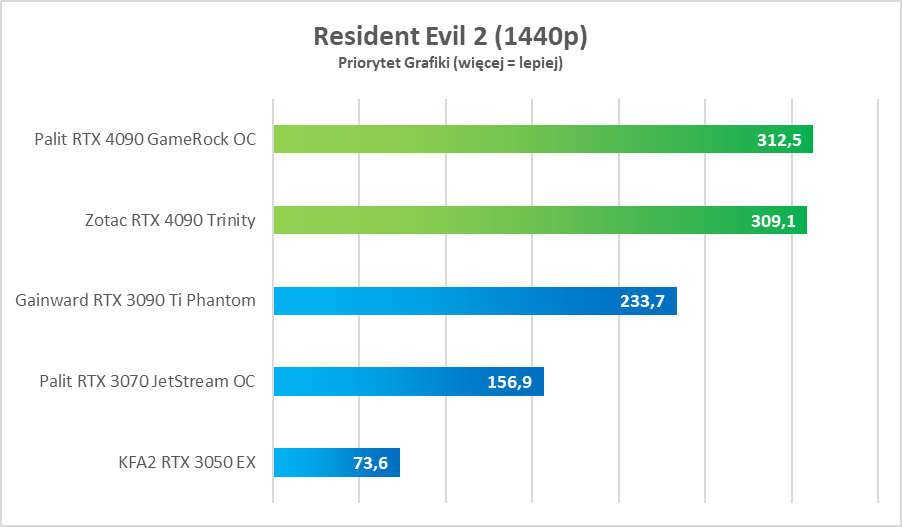

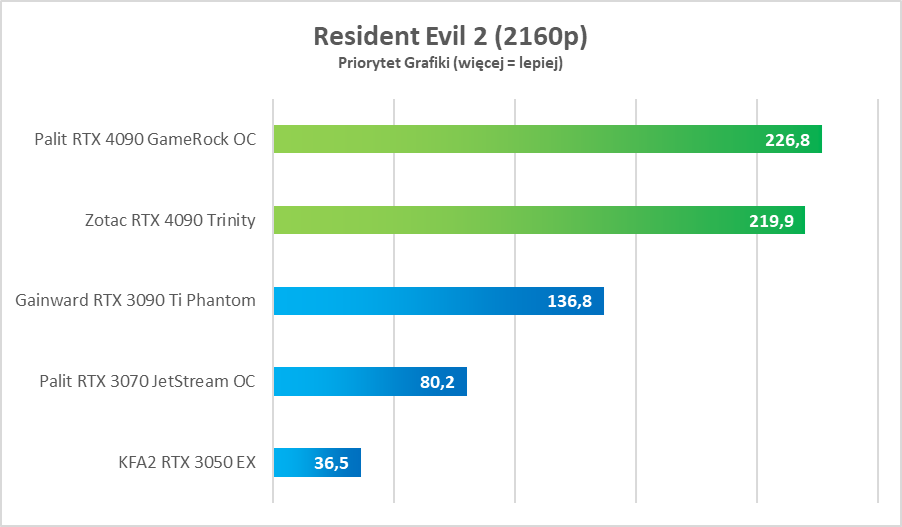

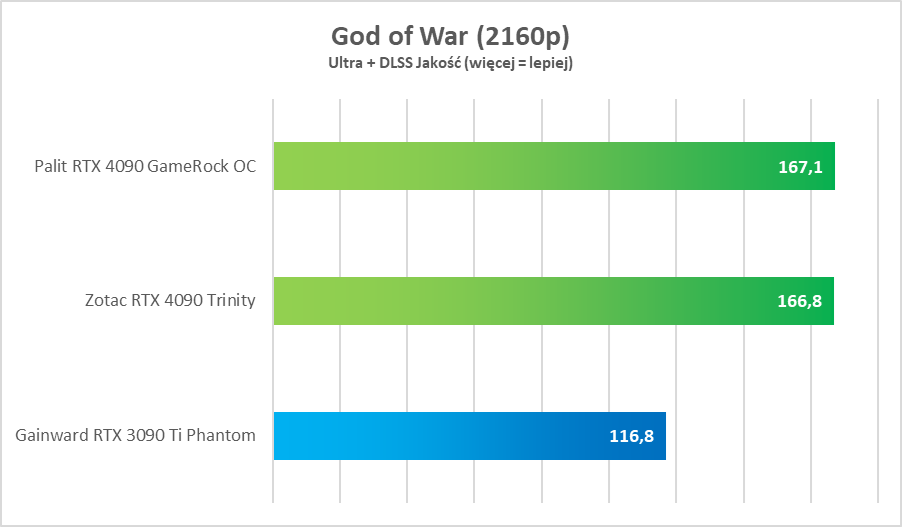

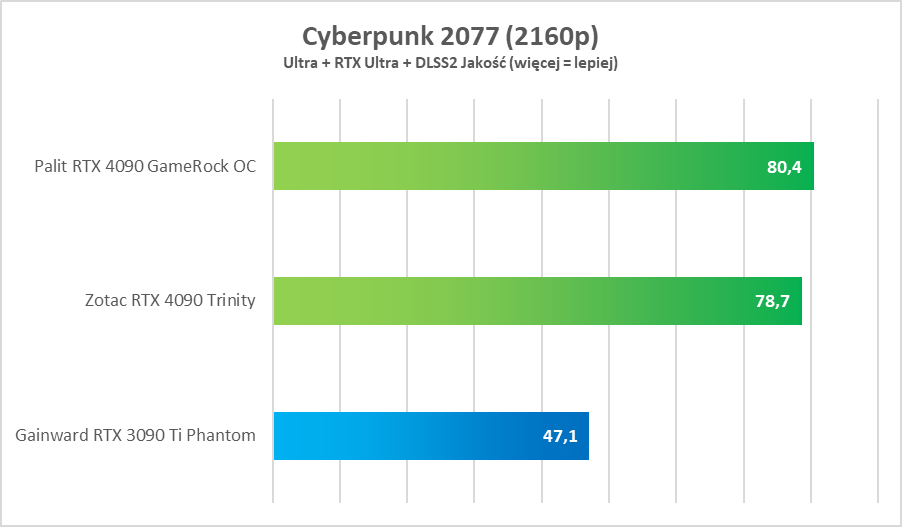

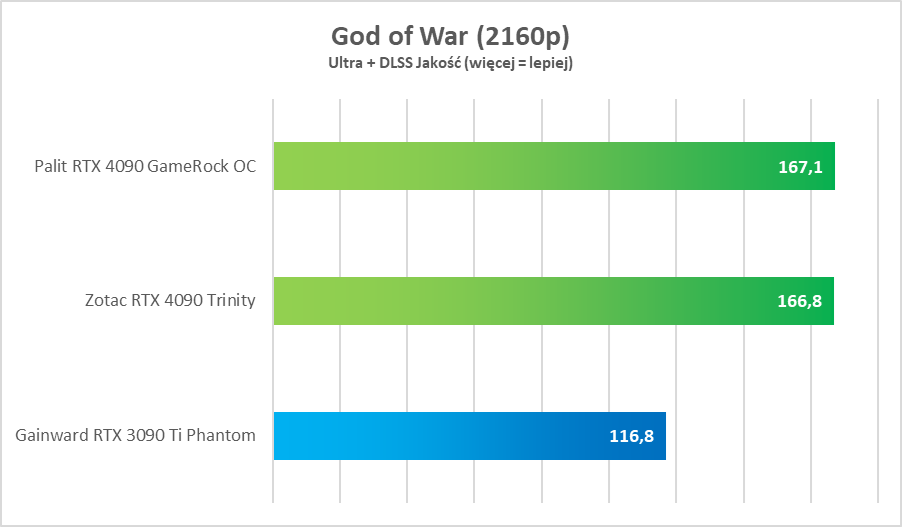

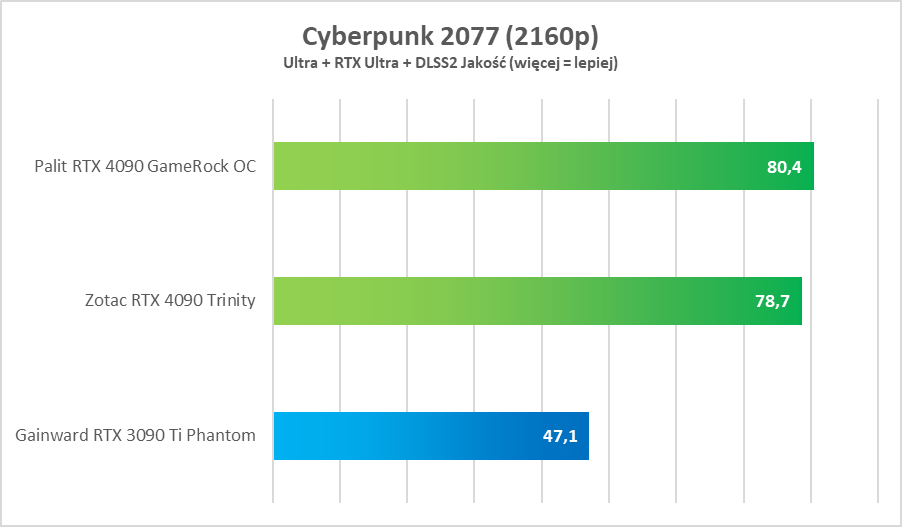

W związku z wymianą procesora i płyty głównej (wcześniej testowaliśmy na Core i9-10900F) postanowiliśmy też zmienić listę gier, na których testujemy karty graficzne. Aktualna lista prezentuje się następująco: Wiedźmin 3, Cyberpunk 2077, Resident Evil 2 oraz God of War. Standardowo testy wykonujemy w rozdzielczości 1080, 1440p oraz 2160p. Nie brakuje też testów z wykorzystaniem NVIDIA DLSS oraz Ray Tracingu, a w przypadku RTX 4090 dodatkowo mieliśmy okazję sprawdzić możliwości DLSS3 w grze Cyberpunk 2077.

Testy w benchmarkach

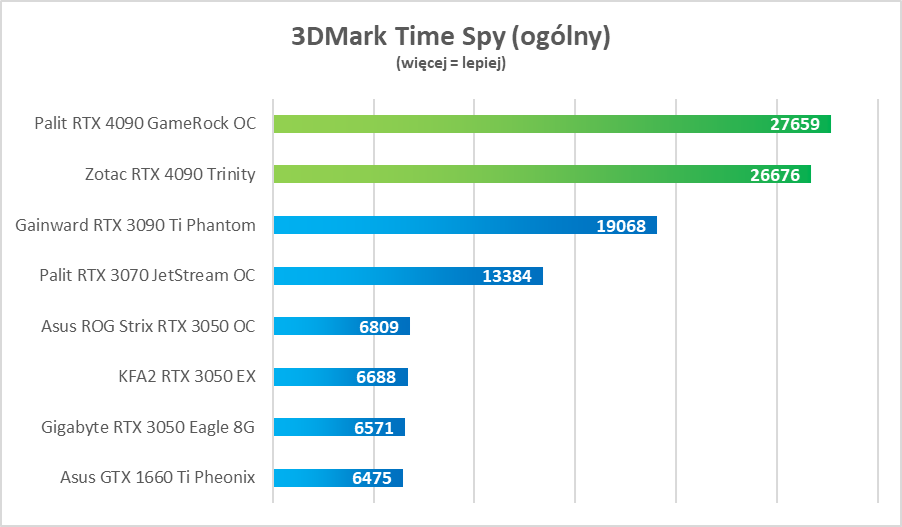

Jak już zaznaczyłem przy platformie testowej i metodologii testów, liczbę benchmarków ograniczyliśmy do minimum. To dobre narzędzie porównawcze, ale nie oddaje realnych możliwości kart graficznych. A przecież wszystkich interesuje to, ile fps-ów będą mieli w najnowszych grach, a nie ile punktów zdobędą w 3DMarku. Niemniej jako narzędzie do zestawiania ze sobą różnych modeli sprawdza się nieźle, więc całkowicie z benchmarków zrezygnować nie wypada.

Jednak liczbę benchmarków ograniczamy do minimum. Dlatego na liście znajdują się jedynie: 3DMark Time Spy (wynik ogólny i GPU), 3DMark Port Royal (test wydajności przy śledzeniu promieni) oraz Blender, który ma pokazywać możliwości danej karty w zastosowaniach profesjonalnych. W przypadku Palit GeForce RTX 4090 GameRock OC wyniki prezentują następująco:

Testy w grach

Jeśli chodzi o testy w grach, to postawiliśmy na cztery tytuły: Cyberpunk 2077 (okolice Grand Mall), Wiedźmin 3: Dziki Gon (Krzywuchowe Moczary), God of War (Rzeczna Przełęcz) oraz Resident Evil 2 (Posterunek Policji). Testy wykonujemy zawsze przy tych samych ustawieniach, w tym samym scenach i w trzech różnych rozdzielczościach, czyli 1080p, 1440p oraz 4K.

Testy RTX/DLSS (w tym DLSS3)

Dodatkowo, oprócz wydajności przy standardowych ustawieniach, sprawdzamy też wpływ RTX (Ray Tracing) i DLSS (Deep Learning Super Sampling), o ile w danej produkcji jest to możliwe. Oba rozwiązania mają gigantyczny wpływ na liczbę generowanych klatek na sekundę, przy czym Ray Tracing je zmniejsza, a DLSS zwiększa (w zależności od ustawień mniej lub więcej).

Przy testach GeForce RTX 4090 dochodzi jeszcze osobny test DLSS3, gdyż otrzymaliśmy dostęp do przedpremierowej wersji Cyberpunk 2077, która to rozwiązanie obsługuje. W tym przypadku ograniczyliśmy się jednak do wbudowanego w grę benchmarka oraz pomiarów za pomocą programu NVIDIA FrameView. Zestawiliśmy jest z identycznymi ustawieniami w DLSS2 oraz z wyłączonym DLSS i RTX.

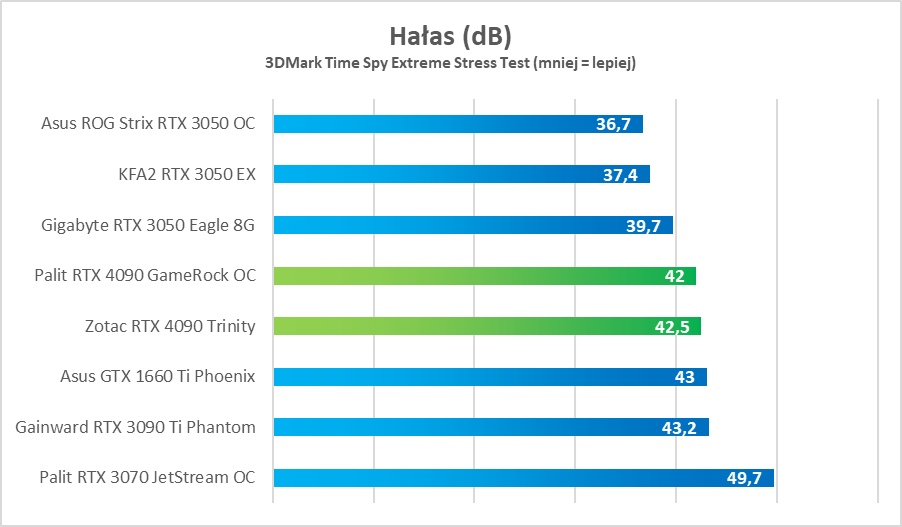

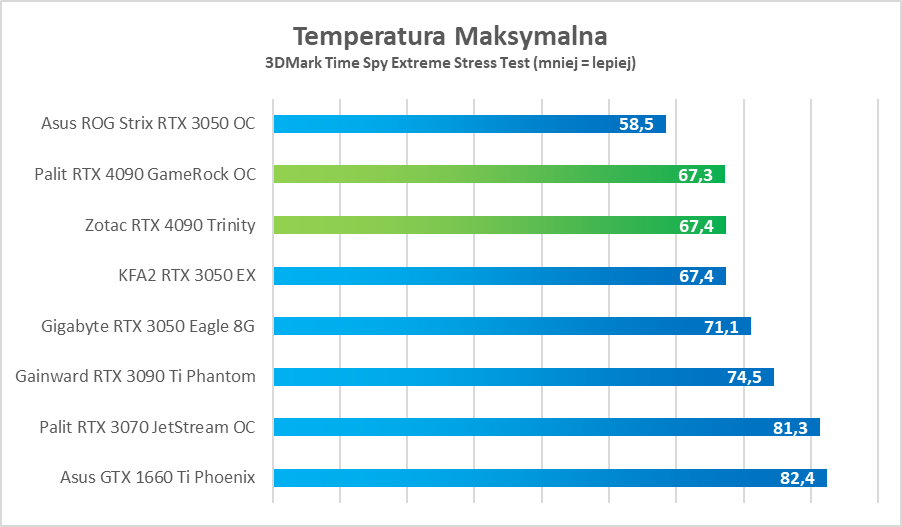

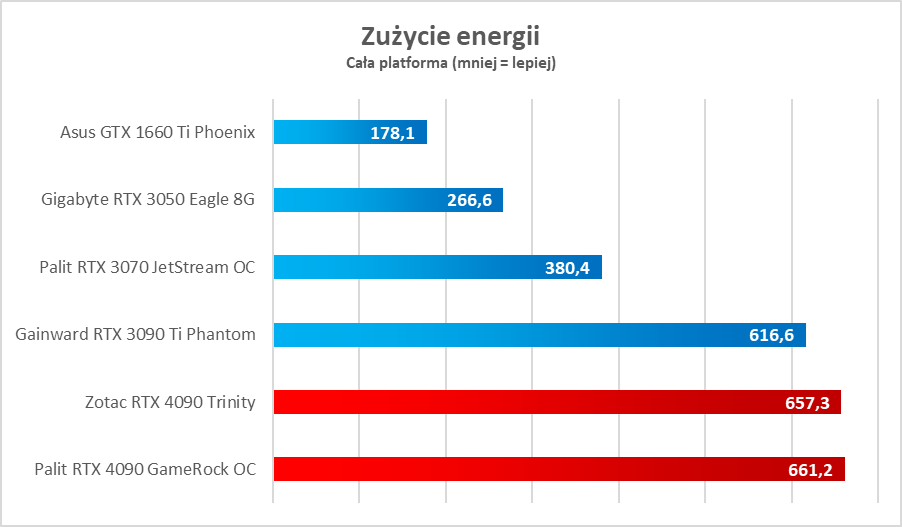

Kultura pracy

W przypadku kultury pracy badamy trzy parametry pracy karty graficznej – maksymalne zużycie energii (dla całej platformy), temperatury osiągane pod obciążeniem oraz hałas generowany przez system chłodzenia danego modelu. W tym ostatnim przypadku pomiaru dokonujemy z odległości około 40 cm ze zdjętym bokiem obudowy, więc w praktyce hałas powinien być niższy. Wszystkie testy wykonujemy w grze Cyberpunk 2077 na najwyższych ustawieniach (RTX na Niewiarygodne) z wyłączony DLSS i w rozdzielczości 4K.

Podsumowanie

Palit GeForce RTX 4090 GameRock OC to karta potężna i nie mam tutaj na myśli tylko wydajności. Wymiary aż 329,4 × 137,5 × 71,5 mm, co przekłada się na zajęcie 3,5 slota w obudowie komputera, to nie jest norma w przypadku GPU, a przynajmniej nie była. Jednak w kontekście modeli z serii RTX 4090 musimy się z tym pogodzić. Wyższa wydajność, pomimo zmniejszenia litografii, w której produkowane są rdzenie Lovelace, idzie w parze ze zwiększonym zapotrzebowaniem na prąd i tym samym wyższym poziomem generowanego ciepła. Może nam się to nie podobać, ale takie są niestety realia. Z drugiej strony różnica względem RTX 3090 Ti wydaje się znikoma i to pomimo TGP wyższego aż o 100 W. Nie zmienia to faktu, że prawie 670 W pobierane przez cały komputer to wartość, która w dobie rosnących cen za prąd, może powodować zawroty głowy.

Natomiast karta Palita zachwyca pod względem kultury pracy. Pomimo wysiłków nie udało mi się rozgrzać jej do wyższej temperatury niż 67 stopni Celsjusza. Weźcie jednak pod uwagę, że wszystkie testy wykonywałem z otwartą obudową, więc w rzeczywistości, gdy buda będzie zamknięta, temperatura procesora graficznego może urosnąć do wyższych poziomów. Dzięki temu GeForce RTX 4090 pozostawał też zaskakująco cichy, generując zaledwie 42 dB z odległości około 40 cm. W praktyce przekładało się to co najwyżej na lekki szum, który w żaden sposób nie przeszkadzał w grze, a przy założonych słuchawkach był po prostu niesłyszalny.

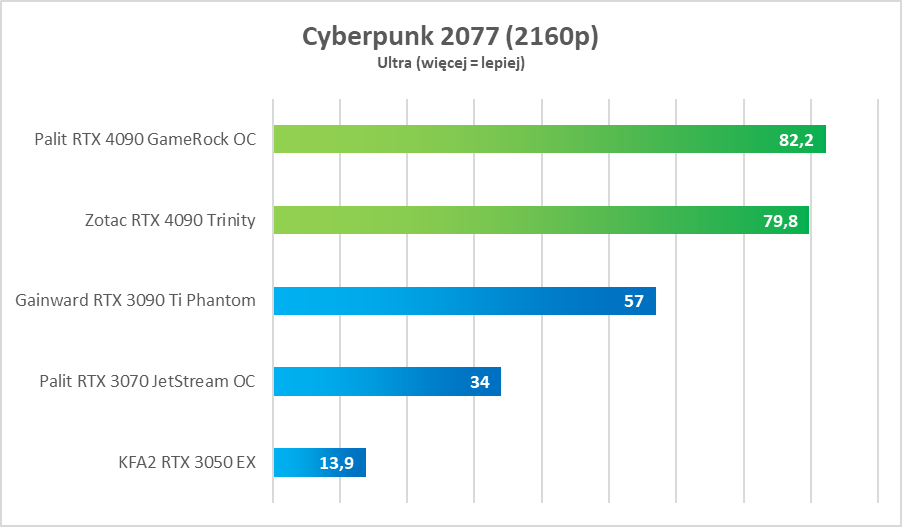

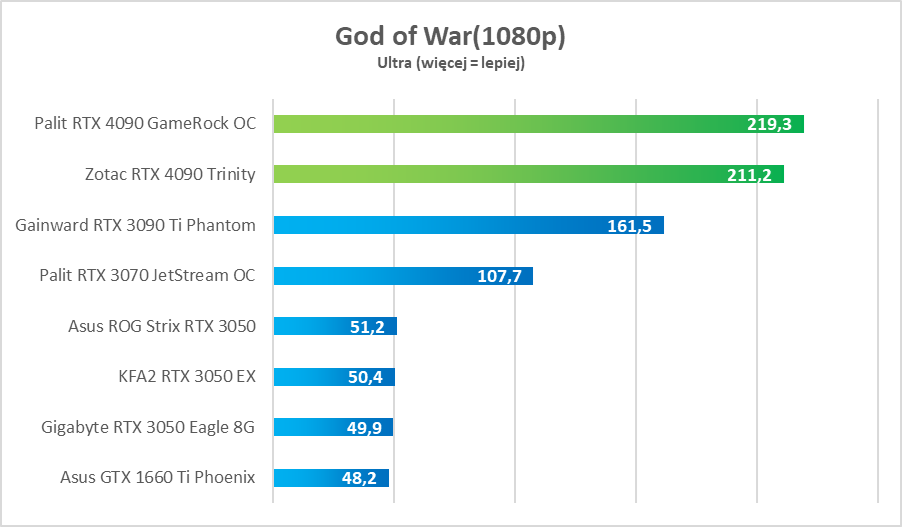

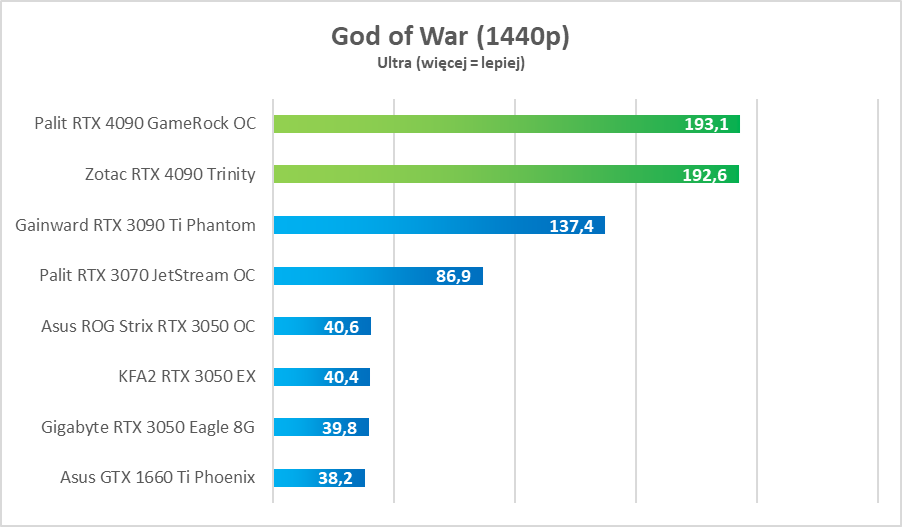

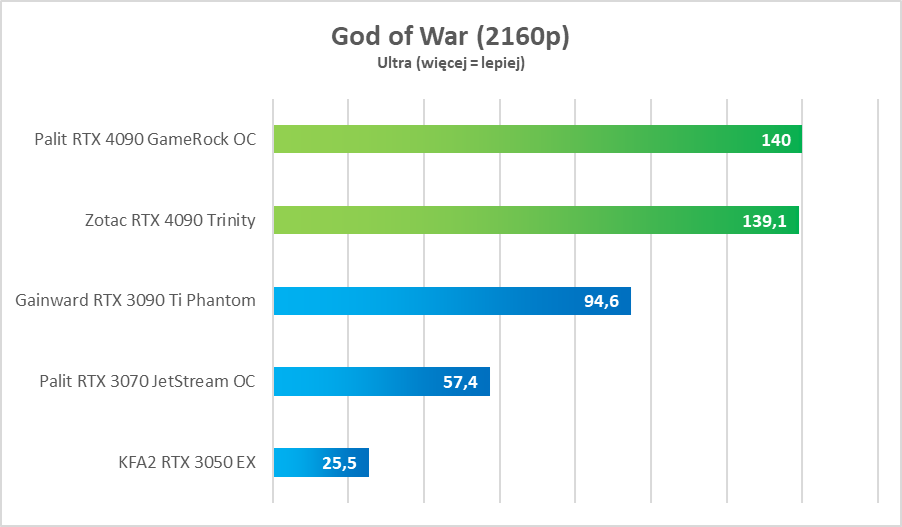

Jeśli chodzi o wydajność, to GeForce RTX 4090 w końcu jest kartą, która pozwoli na w pełni komfortowe granie w rozdzielczości 4K, czyli z płynnością powyżej 60 klatek na sekundę. Nawet w Cyberpunk 2077 przy ustawieniach Ultra (bez RTX i DLSS) GPU generował ponad 80 fps-ów w okolicach Grand Mall, czyli na otwartym terenie. To imponujący wynik, który da się powtórzyć z włączonym Ray Tracingiem, o ile dodatkowo włączymy też NVIDIA DLSS (wystarczy ustawienie „jakość”, aby uzyskać około 80 klatek na sekundę). W mniej wymagających grach nawet w 4K można wykorzystać możliwości monitorów o odświeżaniu 144 Hz.

Jednak z GeForce RTX 4090 jest jeden problem. To karta, która pełnię swoich możliwości pokazuje właśnie w 4K, a w 1440p (nie mówiąc już o 1080p) wydaje się niewykorzystywana. Dlatego jej zakup wiąże się z dodatkowymi kosztami, bo nie tylko monitor powinien wyświetlać obraz w 2160p, ale też powinien go odświeżać z częstotliwością przynajmniej 144 Hz, aby z tej płynności w pełni skorzystać.

Poza tym nie obejdzie się bez naprawdę mocnego zestawu. Nasz testowy Intel Core i9-11900K okazał się ograniczeniem dla RTX-a 4090. Widać to po wynikach w rozdzielczości 1080p, gdzie różnice względem 1440p często są bardzo niewielkie. CPU po prostu nie był w stanie wykrzesać z siebie więcej i stawiał się tzw. wąskim gardłem. Widać to też po testach w grze Marvel’s Spider-Man Remastered, których nie opublikowałem. Musicie tylko wiedzieć, że w rozdzielczościach 1080p, 1440p i 2160p wyniki różniły się zaledwie o kilka klatek na sekundę. Jasne, jest to gra, która mocno siedzi na „CPU”, ale aż tak duże ograniczenie mocy 4090 jest wręcz szokujące. Prawdopodobnie najlepszym wyborem będą najnowsze procesory Intel Core 13. generacji z modelem Core i9-13900K na czele. Podejrzewam, że dopiero on będzie w stanie wykrzesać z karty pełnię jej mocy.

Na osoby akapit zasługuje też NVIDIA DLSS3, czyli nowa wersja techniki skalowania obrazu z wykorzystaniem uczenia maszynowego. Przedpremierowo sprawdziliśmy ją w grze Cyberpunk 2077 (konieczne było do tego zainstalowanie specjalnej wersji gry, udostępnionej dla dziennikarzy). Wyniki porównałem między innymi do DLSS2 i są naprawdę spektakularne. O ile wcześniejszy wzrost wydajności z 74 do 103 klatek na sekundę był imponujący, tak w przypadku DLSS3 płynność rośnie aż do 140 fps-ów, czyli niemal dwukrotnie. Co ważne, w teście nie włączyłem tylko DLSS3, ale też RTX w ustawieniach Ultra, a pomimo tego różnica jest kolosalna. Poza tym, mimo ustawienia DLSS w trybie „wydajności” naprawdę trudno gołym okiem dostrzec jakiekolwiek różnice w jakości obrazu. W niedalekiej przyszłości planuję na ten temat osoby tekst, gdzie dokładnie porównamy sobie obraz natywny i ten skalowany przez rdzenie Tensor.

GeForce RTX 4090 to prawdziwa bestia w każdym tego słowa znaczeniu. Wzrost wydajności w grach względem modelu RTX 3090 Ti jest ogromny i granie w rozdzielczości 4K w więcej niż 60 klatkach stało się w końcu możliwe. Po włączeniu DLSS3 zapas mocy jest jeszcze większy. Jednocześnie nie obejdzie się bez potężnego zestawu, który nie będzie ograniczał GPU, a także mocarnego zasilacza. Chociaż nasz XPG o mocy 850 W dawał radę, to jednak rekomendowałbym korzystanie z mocniejszego. Sam Palit zaleca PSU o mocy przynajmniej 1200 W, co akurat uważam za dużą przesadę. Myślę, że 1000 W w zupełności wystarczy.

Ocena: 9/10

Zalety:

- Ogromna wydajność

- Wysoka kultura pracy

- Ciekawy design z podświetleniem ARGB

- Ray Tracing

- DLSS3 przynosi dużą poprawę wydajności

- Prawdziwa, nowa generacja GPU

- Cena, nawet jeśli to 9449 zł

Wady:

- Duże zużycie energii

- Bez potężnego CPU nawet nie podchodź

- Ogromne wymiary